Grupowy sposób obsługi danych - Group method of data handling

Grupowa metoda przetwarzania danych (GMDH) to rodzina algorytmów indukcyjnych do komputerowego modelowania matematycznego wieloparametrycznych zbiorów danych, która umożliwia w pełni automatyczną optymalizację strukturalną i parametryczną modeli.

GMDH znajduje zastosowanie w takich dziedzinach jak eksploracja danych , odkrywanie wiedzy , predykcja , modelowanie złożonych systemów , optymalizacja i rozpoznawanie wzorców . Algorytmy GMDH charakteryzują się procedurą indukcyjną, która dokonuje sortowania stopniowo skomplikowanych modeli wielomianowych i wyboru najlepszego rozwiązania za pomocą kryterium zewnętrznego .

Model GMDH z wieloma wejściami i jednym wyjściem jest podzbiorem składników funkcji bazowej (1):

gdzie f i to funkcje elementarne zależne od różnych zbiorów danych wejściowych, a i to współczynniki, a m to liczba podstawowych składników funkcji.

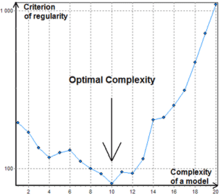

W celu znalezienia najlepszego rozwiązania algorytmy GMDH uwzględniają różne podzbiory składowe funkcji bazowej (1) zwane modelami częściowymi . Współczynniki tych modeli są szacowane metodą najmniejszych kwadratów . Algorytmy GMDH stopniowo zwiększają liczbę częściowych składowych modelu i znajdują strukturę modelu o optymalnej złożoności wskazywanej przez minimalną wartość kryterium zewnętrznego . Proces ten nazywa się samoorganizacją modeli.

Jako pierwszą funkcję bazową używaną w GMDH był stopniowo skomplikowany wielomian Kołmogorowa-Gabor (2):

Zwykle stosuje się prostsze modele częściowe z funkcjami do drugiego stopnia.

Algorytmy indukcyjne znane są również jako wielomianowe sieci neuronowe . Jürgen Schmidhuber wymienia GMDH jako jedną z pierwszych metod głębokiego uczenia , zauważając, że była ona wykorzystywana do trenowania ośmiowarstwowych sieci neuronowych już w 1971 roku.

Historia

Metoda została zapoczątkowana w 1968 roku przez prof. Aleksieja G. Iwachnienkę w Instytucie Cybernetyki w Kijowie . To indukcyjne podejście od samego początku było metodą komputerową, więc zestaw programów komputerowych i algorytmów był podstawowymi praktycznymi wynikami osiągniętymi na podstawie nowych zasad teoretycznych. Dzięki prowadzonej przez autora polityce otwartego współdzielenia kodu metoda szybko została zadomowiona w dużej liczbie laboratoriów naukowych na całym świecie. Ponieważ większość rutynowej pracy jest przenoszona do komputera, wpływ ludzkiego wpływu na obiektywny wynik jest zminimalizowany. W rzeczywistości takie podejście można uznać za jedną z implementacji tezy o Sztucznej Inteligencji , która mówi, że komputer może pełnić rolę potężnego doradcy dla ludzi.

Rozwój GMDH polega na syntezie idei z różnych dziedzin nauki: cybernetycznej koncepcji „ czarnej skrzynki ” i zasady sukcesywnej selekcji genetycznej cech parami , twierdzeń o niezupełności Godla oraz zasady „wolności decyzji” Gabora , w Adhémar za nieprawidłowości, a Beera zasada dodawania zewnętrznych.

GMDH jest oryginalną metodą rozwiązywania problemów identyfikacji strukturalno-parametrycznej modeli dla danych eksperymentalnych w warunkach niepewności . Taki problem pojawia się przy budowie modelu matematycznego, który aproksymuje nieznany wzorzec badanego obiektu lub procesu. Wykorzystuje informacje o nim, które są domyślnie zawarte w danych. GMDH różni się od innych metod modelowania aktywnym stosowaniem następujących zasad : automatyczne generowanie modeli, niejednoznaczne decyzje i spójna selekcja według kryteriów zewnętrznych w celu znalezienia modeli o optymalnej złożoności. Posiadał autorską wielowarstwową procedurę automatycznego generowania struktury modeli, która imituje proces selekcji biologicznej z uwzględnieniem parami kolejnych cech. Taka procedura jest obecnie stosowana w sieciach głębokiego uczenia . Aby porównać i wybrać optymalne modele, wykorzystuje się dwa lub więcej podzbiorów próbki danych. Pozwala to uniknąć wstępnych założeń, ponieważ podział próby domyślnie uwzględnia różne rodzaje niepewności podczas automatycznej konstrukcji optymalnego modelu.

W trakcie opracowywania powstała organiczna analogia między problemem budowy modeli dla danych zaszumionych a sygnałem przechodzącym przez kanał z szumem . Umożliwiło to położenie fundamentów pod teorię modelowania odpornego na hałas. Głównym wynikiem tej teorii jest to, że złożoność optymalnego modelu predykcyjnego zależy od poziomu niepewności danych: im wyższy ten poziom (np. z powodu szumu) - tym prostszy musi być model optymalny (z mniejszą liczbą szacowanych parametrów). Zapoczątkowało to rozwój teorii GMDH jako indukcyjnej metody automatycznej adaptacji optymalnej złożoności modelu do poziomu zmienności szumu w danych rozmytych . Dlatego GMDH jest często uważany za oryginalną technologię informacyjną do ekstrakcji wiedzy z danych eksperymentalnych .

Okres 1968–1971 charakteryzuje się stosowaniem jedynie kryterium prawidłowości do rozwiązywania problemów identyfikacji, rozpoznawania wzorców i prognozowania krótkookresowego. Jako funkcje odniesienia wykorzystano wielomiany, sieci logiczne, rozmyte zbiory Zadeha oraz wzory prawdopodobieństwa Bayesa. Autorzy byli zainspirowani bardzo dużą dokładnością prognozowania w nowym podejściu. Nie badano odporności na hałas.

Okres 1972-1975 . Rozwiązano problem modelowania danych zaszumionych i niepełnej bazy informacyjnej. Zaproponowano wybór wielokryterialny i wykorzystanie dodatkowych informacji priorytetowych dla zwiększenia odporności na hałas. Najlepsze eksperymenty wykazały, że przy rozszerzonej definicji modelu optymalnego o dodatkowe kryterium poziom szumu może być dziesięciokrotnie większy niż sygnał. Następnie został ulepszony przy użyciu teorii Shannona o ogólnej komunikacji.

Okres 1976-1979 . Zbadano zbieżność wielowarstwowych algorytmów GMDH. Wykazano, że niektóre algorytmy wielowarstwowe mają „błąd wielowarstwowości” – analogiczny do błędu statycznego układów sterowania. W 1977 roku zaproponowano rozwiązanie problemów obiektywnej analizy systemów za pomocą wielowarstwowych algorytmów GMDH. Okazało się, że sortowanie według zbioru kryteriów znajduje jedyny optymalny układ równań, a zatem pokazuje złożone elementy obiektu, ich główne zmienne wejściowe i wyjściowe.

Okres 1980-1988 . Otrzymano wiele ważnych wyników teoretycznych. Stało się jasne, że do prognozowania długoterminowego nie można używać pełnych modeli fizycznych. Wykazano, że niefizyczne modele GMDH są dokładniejsze do aproksymacji i prognozowania niż fizyczne modele analizy regresji. Opracowano dwupoziomowe algorytmy wykorzystujące do modelowania dwie różne skale czasowe.

Od 1989 roku opracowywano i badano nowe algorytmy (AC, OCC, PF) do nieparametrycznego modelowania obiektów rozmytych oraz SLP dla systemów ekspertowych. Obecny etap rozwoju GMDH można opisać jako rozkwit neuronetów głębokiego uczenia się i równoległych algorytmów indukcyjnych dla komputerów wieloprocesorowych.

Kryteria zewnętrzne

Kryterium zewnętrzne jest jedną z kluczowych cech GMDH. Kryterium opisuje wymagania dla modelu, na przykład minimalizację najmniejszych kwadratów . Oblicza się ją zawsze z wydzieloną częścią próby danych, która nie została wykorzystana do estymacji współczynników. Umożliwia to wybór modelu o optymalnej złożoności w zależności od poziomu niepewności danych wejściowych. Istnieje kilka popularnych kryteriów:

- Kryterium regularności (CR) – Najmniejsze kwadraty modelu w próbce B.

- Kryterium minimalnego obciążenia lub spójności – kwadrat błędu różnicy między oszacowanymi wynikami (lub wektorami współczynników) dwóch modeli opracowanych na podstawie dwóch różnych próbek A i B, podzielony przez kwadrat wyniku oszacowanego na próbie B. Porównanie modeli z jego wykorzystaniem , umożliwia uzyskanie spójnych modeli i odzyskanie ukrytego prawa fizycznego z zaszumionych danych.

- Kryteria walidacji krzyżowej .

Prosty opis tworzenia modelu z wykorzystaniem GMDH

W przypadku modelowania z wykorzystaniem GMDH wstępnie wybierane jest tylko kryterium wyboru i maksymalna złożoność modelu. Następnie proces projektowania rozpoczyna się od pierwszej warstwy i trwa. Liczba warstw i neuronów w warstwach ukrytych, struktura modelu są określane automatycznie. Można rozważyć wszystkie możliwe kombinacje dopuszczalnych wejść (wszystkie możliwe neurony). Następnie współczynniki wielomianu są wyznaczane za pomocą jednej z dostępnych metod minimalizacji, takiej jak dekompozycja na wartości osobliwe (z danymi uczącymi). Następnie neurony, które mają lepszą wartość kryterium zewnętrznego (dla danych testowych) są zachowywane, a inne są usuwane. Jeżeli zewnętrzne kryterium najlepszego neuronu warstwy osiągnie minimum lub przekroczy kryterium zatrzymania, projekt sieci jest zakończony i wielomianowe wyrażenie najlepszego neuronu ostatniej warstwy jest wprowadzane jako matematyczna funkcja predykcji; jeśli nie, zostanie wygenerowana następna warstwa i ten proces będzie kontynuowany.

Sieci neuronowe typu GMDH

Istnieje wiele różnych sposobów wyboru zamówienia do rozważenia modeli częściowych. Najbardziej popularna jest pierwsza kolejność rozważań stosowana w GMDH i pierwotnie nazywana wielowarstwową procedurą indukcyjną. Jest to uporządkowanie stopniowo skomplikowanych modeli generowanych z funkcji bazowej . Na najlepszy model wskazuje minimum zewnętrznej cechy kryterium. Procedura wielowarstwowa jest odpowiednikiem Sztucznej Sieci Neuronowej z wielomianową funkcją aktywacji neuronów. Dlatego algorytm z takim podejściem zwykle określany jest jako sieć neuronowa typu GMDH lub sieć neuronowa wielomianowa. Li wykazał, że sieć neuronowa typu GMDH działała lepiej niż klasyczne algorytmy prognozowania, takie jak Single Exponential Smooth, Double Exponential Smooth, ARIMA i sieć neuronowa z propagacją wsteczną.

Kombinatoryczna GMDH

Innym ważnym podejściem do rozważania modeli częściowych, które staje się coraz bardziej popularne, jest wyszukiwanie kombinatoryczne, które jest albo ograniczone, albo pełne. Podejście to ma pewne zalety w porównaniu z wielomianowymi sieciami neuronowymi, ale wymaga znacznej mocy obliczeniowej, a zatem nie jest skuteczne w przypadku obiektów z dużą liczbą danych wejściowych. Ważnym osiągnięciem kombinatorycznej GMDH jest to, że w pełni przewyższa podejście oparte na regresji liniowej, jeśli poziom szumu w danych wejściowych jest większy od zera. Gwarantuje to, że podczas wyczerpującego sortowania powstanie najbardziej optymalny model.

Podstawowy algorytm kombinatoryczny wykonuje następujące kroki:

- Dzieli próbkę danych co najmniej na dwie próbki A i B.

- Generuje podpróbki z A zgodnie z modelami częściowymi o stale rosnącej złożoności.

- Szacuje współczynniki modeli cząstkowych w każdej warstwie złożoności modeli.

- Oblicza wartość kryterium zewnętrznego dla modeli na próbie B.

- Wybiera najlepszy model (zestaw modeli) wskazany przez minimalną wartość kryterium.

- Dla wybranego modelu optymalnej złożoności przelicz współczynniki na całej próbce danych.

W przeciwieństwie do sieci neuronowych typu GMDH Algorytm kombinatoryczny zwykle nie zatrzymuje się na pewnym poziomie złożoności, ponieważ punkt wzrostu wartości kryterium może być po prostu lokalnym minimum, patrz rys.1.

Algorytmy

- Kombinatoryczny (COMBI)

- Wielowarstwowa iteracja (MIA)

- GN

- Obiektywna analiza systemu (OSA)

- Harmoniczne

- Dwupoziomowy (ARIMAD)

- Mnożnik–dodatek (MAA)

- Cel Klasteryzacji Komputerów (OCC);

- Algorytm klasteryzacji palca wskazującego (PF);

- Kompleksowanie analogów (AC)

- Redyskretyzacja harmoniczna

- Algorytm na podstawie Wielowarstwowej Teorii Decyzji Statystycznych (MTSD)

- Grupa Ewolucji Modeli Adaptacyjnych (GAME)

Lista oprogramowania

- MATLAB

- Projekt FAKE GAME — Open source. Wieloplatformowy.

- GEvom — bezpłatnie na życzenie do użytku akademickiego. Tylko w systemie Windows.

- GMDH Shell — oparte na GMDH oprogramowanie do analiz predykcyjnych i prognozowania szeregów czasowych. Dostępna jest bezpłatna licencja akademicka i bezpłatna wersja próbna. Tylko w systemie Windows.

- KnowledgeMiner — produkt komercyjny. Tylko Mac OS X. Dostępna bezpłatna wersja demonstracyjna.

- Klient PNN Discovery — Produkt komercyjny.

- Naukowe RPF! — Freeware, Open source.

- wGMDH — wtyczka Weka , Open source.

- Pakiet R – Open source.

- Pakiet R dla zadań regresji – Open source.

- Biblioteka Pythona algorytmu MIA - Open source.

Bibliografia

Zewnętrzne linki

Dalsza lektura

- AG Iwachnenko. Heurystyczna samoorganizacja w problemach cybernetyki inżynierskiej , Automatica, t. 6, 1970 — s. 207-219.

- SJ Farlowa . Metody samoorganizujące się w modelowaniu: Algorytmy typu GMDH . Nowy Jork, Bazel: Marcel Decker Inc., 1984, 350 s.

- HR Madala, AG Iwachnenko. Algorytmy uczenia indukcyjnego do modelowania systemów złożonych . CRC Press, Boca Raton, 1994.