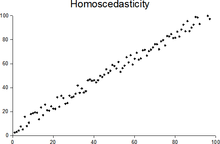

Homoskedastyczność - Homoscedasticity

W statystycznych , A sekwencję (lub wektorem) o zmiennych losowych jest homoscedastic / ˌ H oʊ m oʊ y k ə d ć s t ɪ K / wtedy, gdy wszystkie jej przypadkowe zmienne mają takie samo skończonej wariancji . Jest to również znane jako jednorodność wariancji . Pojęcie komplementarne nazywa się heteroskedastycznością . Często używa się również pisowni homos k edasticity i heteros k edasticity .

Zakładając, że zmienna jest homoscedastic gdy w rzeczywistości jest to heteroskedastyczny ( / ˌ h ɛ t ər oʊ s k ə d ć s t ɪ k / ) powoduje bezstronnych ale nieefektywne oszacowań punktowych iw tendencyjne szacunków standardowych błędów i może skutkować przeszacowanie dobroci dopasowania mierzonej współczynnikiem Pearsona .

Założenia modelu regresji

Standardowa założenie w regresji liniowej , że wariancja terminu zakłóceń jest taki sam na obserwacji, a w szczególności nie zależy od wartości zmienne objaśniające Jest to jeden z założenia, pod którym Gaussa-Markowa twierdzenie zastosowanie i zwykły najmniejszych kwadratów (OLS) daje najlepszy liniowy bezstronny estymator („NIEBIESKI”). Homoskedastyczność nie jest wymagana, aby oszacowania współczynnika były bezstronne, spójne i asymptotycznie normalne, ale jest wymagana, aby OLS był skuteczny. Wymagane jest również, aby błędy standardowe oszacowań były bezstronne i spójne, a więc wymagane jest do dokładnego testowania hipotez, np. dla testu t, czy współczynnik jest istotnie różny od zera.

Bardziej formalnym sposobem na stwierdzenie założenia homoskedastyczności jest to, że wszystkie przekątne macierzy wariancji-kowariancji muszą mieć tę samą liczbę: , gdzie jest taka sama dla wszystkich i . Zauważ, że nadal pozwala to, aby niediagonalne, kowariancje , były niezerowe, co jest oddzielnym naruszeniem założeń Gaussa-Markowa, znanych jako korelacja szeregowa.

Przykłady

Poniższe macierze są kowariancjami zakłócenia, z wpisami , gdy istnieją tylko trzy obserwacje w czasie. Zaburzenie w macierzy A jest homoskedastyczne; jest to prosty przypadek, w którym OLS jest najlepszym liniowym bezstronnym estymatorem. Zaburzenia w macierzach B i C są heteroskedastyczne. W macierzy B wariancja jest zmienna w czasie i stale rośnie w czasie; w macierzy C wariancja zależy od wartości x. Zakłócenie w macierzy D jest homoskedastyczne, ponieważ wariancje diagonalne są stałe, mimo że kowariancje pozadiagonalne są niezerowe, a zwykła metoda najmniejszych kwadratów jest nieefektywna z innego powodu: korelacji szeregowej.

Jeśli y jest konsumpcją, x jest dochodem i jest kaprysami konsumenta, a my szacujemy, że jeśli kaprysy bogatszych konsumentów wpływają na ich wydatki w większym stopniu w dolarach bezwzględnych, możemy mieć wzrost wraz z dochodem, jak w macierzy C powyżej.

Testowanie

Reszty można testować pod kątem homoskedastyczności za pomocą testu Breuscha-Pagana , który przeprowadza pomocniczą regresję kwadratów reszt na zmiennych niezależnych. Z tej regresji pomocniczej zachowana jest wyjaśniona suma kwadratów podzielona przez dwa, a następnie staje się statystyką testową dla rozkładu chi-kwadrat o stopniach swobody równych liczbie zmiennych niezależnych. Hipotezą zerową tego testu chi-kwadrat jest homoskedastyczność, a hipoteza alternatywna wskazywałaby na heteroskedastyczność. Ponieważ test Breuscha-Pagana jest czuły na odstępstwa od normalności lub małych liczebności próby, zamiast tego powszechnie stosuje się test Koenkera-Bassetta lub „uogólniony test Breuscha-Pagana”. Z regresji pomocniczej zachowuje wartość R-kwadrat, która jest następnie mnożona przez wielkość próby, a następnie staje się statystyką testową dla rozkładu chi-kwadrat (i używa tych samych stopni swobody). Chociaż nie jest to konieczne dla testu Koenkera-Bassetta, test Breuscha-Pagana wymaga, aby kwadraty reszty były również podzielone przez sumę kwadratów reszt podzieloną przez wielkość próby. Testowanie heteroskedastyczności grupowej wymaga testu Goldfelda-Quandta .

Rozkłady homoskedastyczne

Dwa lub więcej rozkładów normalnych , , są homoskedastyczne, jeśli mają wspólną macierz kowariancji (lub korelacji ), . Rozkłady homoskedastyczne są szczególnie przydatne do uzyskania algorytmów rozpoznawania wzorców statystycznych i uczenia maszynowego . Jednym z popularnych przykładów algorytmu zakładającego homoskedastyczność jest liniowa analiza dyskryminacyjna Fishera .

Pojęcie homoskedastyczności można zastosować do rozkładów na sferach.