Inteligentny agent - Intelligent agent

W sztucznej inteligencji , czynnik inteligentny ( IA ) to wszystko, co postrzega swoje otoczenie, podejmuje działania autonomicznie , aby osiągnąć cele, a może poprawić jego wydajność z nauki lub mogą wykorzystywać wiedzę . Mogą być proste lub złożone — termostat jest uważany za przykład inteligentnego agenta, podobnie jak człowiek, podobnie jak każdy system spełniający definicję, taki jak firma , państwo , czy biom .

Wiodące podręczniki sztucznej inteligencji definiują „sztuczną inteligencję” jako „badanie i projektowanie inteligentnych agentów”, definicję, która uważa zachowanie ukierunkowane na cel za istotę inteligencji. Agenci zorientowani na cel są również opisywani za pomocą terminu zapożyczonego z ekonomii , „ racjonalny agent ”.

Agent pełni „obiektywną funkcję”, która obejmuje wszystkie cele IA. Taki agent jest przeznaczony do tworzenia i wykonywania dowolnego planu, który po zakończeniu zmaksymalizuje oczekiwaną wartość funkcji celu. Na przykład, agent wzmacniający uczenie ma „funkcję nagrody”, która pozwala programistom kształtować pożądane zachowanie IA, a zachowanie algorytmu ewolucyjnego jest kształtowane przez „funkcję sprawności”.

Inteligentni agenci w sztucznej inteligencji są blisko spokrewnieni z agentami w ekonomii , a wersje paradygmatu inteligentnego agenta są badane w kognitywistyce , etyce , filozofii rozumu praktycznego , a także w wielu interdyscyplinarnych modelach społeczno-poznawczych i komputerowych symulacjach społecznych .

Agenci inteligentni są często opisywani schematycznie jako abstrakcyjny system funkcjonalny podobny do programu komputerowego. Abstrakcyjne opisy inteligentnych agentów nazywane są abstrakcyjnymi inteligentnymi agentami ( AIA ), aby odróżnić je od ich implementacji w świecie rzeczywistym. Autonomiczny inteligentny środek jest przeznaczony do funkcjonowania w braku interwencji człowieka. Inteligentni agenci są również ściśle powiązani z agentami oprogramowania (autonomicznym programem komputerowym, który wykonuje zadania w imieniu użytkowników).

Definicja sztucznej inteligencji

Informatyka definiuje badania AI jako badanie inteligentnych agentów . Wiodącym AI podręcznik definiuje „agent” jako:

- „Wszystko, co można postrzegać jako postrzeganie otoczenia za pomocą czujników i oddziaływanie na to środowisko za pomocą siłowników”

definiuje „racjonalnego agenta” jako:

- „Agent, który działa tak, aby zmaksymalizować oczekiwaną wartość miernika wydajności w oparciu o przeszłe doświadczenie i wiedzę”.

i definiuje dziedzinę badań „sztucznej inteligencji” jako:

- „Badanie i projektowanie racjonalnych czynników”

Podobną definicję sztucznej inteligencji podają Kaplan i Haenlein: „Zdolność systemu do poprawnej interpretacji danych zewnętrznych, uczenia się na podstawie takich danych i wykorzystywania tych wiedzy do osiągania określonych celów i zadań poprzez elastyczną adaptację”.

Padgham i Winikoff (2005) zgadzają się, że inteligentny agent znajduje się w środowisku i reaguje (w odpowiednim czasie, choć niekoniecznie w czasie rzeczywistym) na zmiany środowiska. Jednak inteligentni agenci muszą również proaktywnie realizować cele w elastyczny i niezawodny sposób. Ewentualne dezyderaty obejmują, aby agent był racjonalny i aby agent był zdolny do analizy przekonania-pragnienia-intencji .

Zalety tej definicji

Filozoficznie unika kilku linii krytyki. W przeciwieństwie do testu Turinga nie odnosi się w żaden sposób do ludzkiej inteligencji. Zatem nie ma potrzeby dyskutować, czy jest to inteligencja „prawdziwa” czy „symulowana” (tj. inteligencja „syntetyczna” czy „sztuczna”) i nie wskazuje na to, że taka maszyna ma umysł , świadomość lub prawdziwe zrozumienie (tj. nie implikuje to „ hipotezy silnej sztucznej inteligencji ” Johna Searle'a ). Nie próbuje również nakreślić ostrej linii podziału między zachowaniami „inteligentnymi” a zachowaniami „nieinteligentnymi” – programy muszą być mierzone jedynie pod kątem ich funkcji celu.

Co ważniejsze, ma wiele praktycznych zalet, które pomogły w rozwoju badań nad sztuczną inteligencją. Zapewnia niezawodny i naukowy sposób testowania programów; badacze mogą bezpośrednio porównywać lub nawet łączyć różne podejścia do pojedynczych problemów, pytając, który agent najlepiej maksymalizuje daną „funkcję celu”. Daje im również wspólny język do komunikowania się z innymi dziedzinami — takimi jak optymalizacja matematyczna (która jest definiowana w kategoriach „celów”) lub ekonomia (która wykorzystuje tę samą definicję „ czynnika racjonalnego ”).

Funkcja celu

Agent, któremu przypisano jawną „funkcję celu”, jest uważany za bardziej inteligentnego, jeśli konsekwentnie podejmuje działania, które skutecznie maksymalizują zaprogramowaną funkcję celu. Cel może być prosty („1 jeśli IA wygra partię w Go , 0 w przeciwnym razie”) lub złożony („Wykonaj działania matematycznie podobne do tych, które zakończyły się sukcesem w przeszłości”). „Funkcja celu” zawiera w sobie wszystkie cele, które agent ma realizować; w przypadku racjonalnych agentów funkcja obejmuje również akceptowalne kompromisy między osiąganiem sprzecznych celów. (Terminologia jest różna; na przykład niektórzy agenci starają się zmaksymalizować lub zminimalizować „ funkcję użyteczności ”, „funkcję celu” lub „ funkcję straty ”.)

Cele można wyraźnie zdefiniować lub wymusić. Jeśli sztuczna inteligencja jest zaprogramowana na „ uczenie się przez wzmacnianie ”, ma „ funkcję nagrody ”, która zachęca do niektórych rodzajów zachowań i karze inne. Alternatywnie, system ewolucyjny może indukować cele, używając „ funkcji sprawności ”, aby mutować i preferencyjnie replikować systemy sztucznej inteligencji o wysokich wynikach, podobnie jak zwierzęta ewoluowały, aby wrodzonym pożądać pewnych celów, takich jak znalezienie pożywienia. Niektóre systemy sztucznej inteligencji, takie jak najbliższy sąsiad, zamiast rozumować przez analogię, generalnie nie otrzymują celów, z wyjątkiem stopnia, w którym cele są ukryte w ich danych treningowych. Takie systemy mogą być nadal testowane, jeśli system nie będący celem jest sformułowany jako system, którego „celem” jest wykonanie zadania wąskiej klasyfikacji.

Systemy, które nie są tradycyjnie uważane za agentów, takie jak systemy reprezentacji wiedzy, są czasami włączane do paradygmatu poprzez określanie ich jako agentów, których celem jest (na przykład) jak najdokładniejsze odpowiadanie na pytania; pojęcie „działania” jest tutaj rozszerzone na „akt” udzielenia odpowiedzi na pytanie. Jako dodatkowe rozszerzenie, systemy oparte na mimice mogą być traktowane jako agenci, którzy optymalizują „funkcję celu” w oparciu o to, jak blisko IA udaje się naśladować pożądane zachowanie. W generatywnych sieciach przeciwników z lat 2010, komponent „kodujący”/„generator” próbuje naśladować i improwizować kompozycję tekstu ludzkiego. Generator próbuje zmaksymalizować funkcję obejmującą, jak dobrze może oszukać antagonistyczny komponent „predyktor”/„dyskryminator”.

Podczas gdy systemy GOFAI często akceptują jawną funkcję celu, paradygmat można również zastosować do sieci neuronowych i obliczeń ewolucyjnych . Uczenie się przez wzmacnianie może generować inteligentnych agentów, którzy wydają się działać w sposób, który ma na celu maksymalizację „funkcji nagrody”. Czasami zamiast ustawiać funkcję nagrody tak, aby była bezpośrednio równa pożądanej funkcji oceny porównawczej, programiści uczenia maszynowego będą używać kształtowania nagrody, aby początkowo przyznać maszynie nagrody za stopniowy postęp w nauce. Yann LeCun stwierdził w 2018 roku, że „Większość algorytmów uczenia się, które ludzie wymyślili, zasadniczo polega na minimalizowaniu niektórych funkcji celu”. Szachy AlphaZero miały prostą funkcję celu; każda wygrana liczyła się jako +1 punkt, a każda przegrana jako -1 punkt. Funkcja celu dla autonomicznego samochodu musiałaby być bardziej skomplikowana. Obliczenia ewolucyjne mogą wyewoluować inteligentnych agentów, którzy wydają się działać w sposób mający na celu maksymalizację „funkcji sprawności”, która wpływa na liczbę potomków, którzy każdy agent może odejść.

Teoretyczny i nieobliczalny projekt AIXI jest w tym paradygmacie maksymalnie inteligentnym agentem; jednak w rzeczywistym świecie IA jest ograniczona ograniczonym czasem i zasobami sprzętowymi, a naukowcy konkurują o stworzenie algorytmów, które mogą osiągać coraz wyższe wyniki w testach porównawczych ze sprzętem w świecie rzeczywistym.

Klasy inteligentnych agentów

Klasyfikacja Russela i Norviga

Russell i Norvig (2003) dzielą agentów na pięć klas na podstawie ich postrzeganej inteligencji i zdolności:

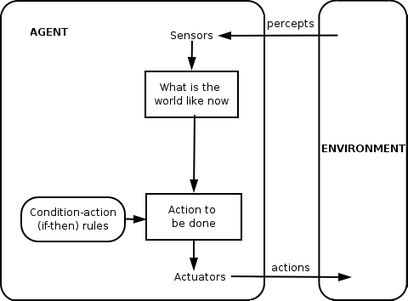

Proste środki odruchowe

Proste czynniki odruchowe działają tylko na podstawie aktualnego percepcji, ignorując resztę historii percepcji. Funkcja agenta opiera się na regule warunek-akcja : „jeśli warunek, to akcja”.

Ta funkcja agenta powiedzie się tylko wtedy, gdy środowisko jest w pełni obserwowalne. Niektóre środki odruchowe mogą również zawierać informacje o ich aktualnym stanie, co pozwala im zignorować warunki, w których aktywatory są już uruchomione.

Nieskończone pętle są często nieuniknione dla prostych agentów odruchowych działających w częściowo obserwowalnych środowiskach. Uwaga: Jeśli agent może losowo wykonywać swoje działania, możliwe jest wyjście z nieskończonych pętli.

Leki odruchowe oparte na modelu

Agent oparty na modelu może obsługiwać środowiska częściowo obserwowalne. Jej aktualny stan jest przechowywany wewnątrz agenta, zachowując pewną strukturę opisującą część świata, której nie można zobaczyć. Ta wiedza o tym, „jak działa świat” nazywana jest modelem świata, stąd nazwa „agent oparty na modelu”.

Agent odruchów oparty na modelu powinien utrzymywać pewien rodzaj modelu wewnętrznego, który zależy od historii percepcji, a tym samym odzwierciedla przynajmniej niektóre nieobserwowane aspekty obecnego stanu. Historię percepcji i wpływ działań na środowisko można określić za pomocą modelu wewnętrznego. Następnie wybiera działanie w taki sam sposób, jak środek odruchowy.

Agent może również używać modeli do opisywania i przewidywania zachowań innych agentów w środowisku.

Agenci zorientowani na cele

Agenty oparte na celach dodatkowo rozszerzają możliwości agentów opartych na modelach, wykorzystując informacje o „celu”. Informacje o celu opisują pożądane sytuacje. Daje to agentowi możliwość wyboru spośród wielu możliwości, wybierając tę, która osiąga stan docelowy. Wyszukiwanie i planowanie to poddziedziny sztucznej inteligencji poświęcone wyszukiwaniu sekwencji działań, które osiągają cele agenta.

Agenci użyteczności publicznej

Agenty oparte na celach rozróżniają tylko stany docelowe i stany niezwiązane z celem. Możliwe jest również określenie miary tego, jak pożądany jest dany stan. Miarę tę można uzyskać za pomocą funkcji użyteczności, która odwzorowuje stan na miarę użyteczności stanu. Bardziej ogólna miara wydajności powinna umożliwiać porównanie różnych stanów świata według tego, jak dobrze spełniały cele agenta. Terminu narzędzie można użyć do opisania, jak „szczęśliwy” jest agent.

Racjonalny agent oparty na użyteczności wybiera działanie, które maksymalizuje oczekiwaną użyteczność wyników działania - to znaczy to, czego agent oczekuje średnio, biorąc pod uwagę prawdopodobieństwa i użyteczność każdego wyniku. Agent oparty na narzędziach musi modelować i śledzić swoje środowisko, zadania, które wymagały wielu badań dotyczących percepcji, reprezentacji, rozumowania i uczenia się.

Agenci uczący się

Uczenie ma tę zaletę, że pozwala agentom początkowo działać w nieznanych środowiskach i stać się bardziej kompetentnymi, niż pozwalała na to sama początkowa wiedza. Najważniejszym rozróżnieniem jest „element uczenia się”, który odpowiada za wprowadzanie ulepszeń, oraz „element wydajności”, który odpowiada za wybór działań zewnętrznych.

Element uczenia się wykorzystuje informacje zwrotne od „krytyka” na temat tego, jak sprawuje się agent, i określa, w jaki sposób element wydajności lub „aktor” powinien zostać zmodyfikowany, aby w przyszłości działał lepiej. Elementem wykonawczym jest to, co wcześniej uważaliśmy za całego agenta: przyjmuje percepcje i decyduje o działaniach.

Ostatnim składnikiem agenta uczącego jest „generator problemów”. Jest odpowiedzialny za proponowanie działań, które doprowadzą do nowych i pouczających doświadczeń.

Klasyfikacja Weissa

Weiss (2013) definiuje cztery klasy agentów:

- Agenty oparte na logice – w których decyzja o tym, jakie działanie wykonać, jest podejmowana na podstawie logicznej dedukcji;

- Czynniki reaktywne – w których podejmowanie decyzji jest realizowane w jakiejś formie bezpośredniego mapowania od sytuacji do działania;

- Podmioty typu przekonanie-pragnienie-intencja – w których podejmowanie decyzji zależy od manipulacji strukturami danych reprezentującymi przekonania, pragnienia i intencje podmiotu; i w końcu,

- Architektury warstwowe – w których podejmowanie decyzji jest realizowane za pomocą różnych warstw oprogramowania, z których każda mniej lub bardziej jednoznacznie uzasadnia środowisko na różnych poziomach abstrakcji.

Hierarchie agentów

Aby aktywnie wykonywać swoje funkcje , Inteligentni agenci są dziś zwykle gromadzeni w hierarchicznej strukturze zawierającej wiele „pod-agentów”. Inteligentne sub-agenty przetwarzają i wykonują funkcje niższego poziomu. Podsumowując, inteligentny agent i podagenty tworzą kompletny system, który może realizować trudne zadania lub cele za pomocą zachowań i reakcji, które wykazują pewną formę inteligencji.

Ogólnie rzecz biorąc, agent może być skonstruowany przez podzielenie ciała na czujniki i elementy wykonawcze, tak aby działał ze złożonym systemem percepcji, który przyjmuje opis świata jako dane wejściowe dla kontrolera i wysyła polecenia do elementu wykonawczego. Jednak hierarchia warstw kontrolera jest często konieczna, aby zrównoważyć natychmiastową reakcję pożądaną w przypadku zadań niskiego poziomu z powolnym rozumowaniem o złożonych, wysokopoziomowych celach.

Funkcja agenta

Prosty program agenta można zdefiniować matematycznie jako funkcję f (zwaną „funkcją agenta”), która odwzorowuje każdą możliwą sekwencję perceptów na możliwą akcję, którą agent może wykonać, lub na współczynnik, element sprzężenia zwrotnego, funkcję lub stałą, która wpływa na ewentualne działania:

Funkcja agenta jest pojęciem abstrakcyjnym, ponieważ może obejmować różne zasady podejmowania decyzji, takie jak obliczanie użyteczności poszczególnych opcji, dedukcja nad regułami logicznymi , logika rozmyta itp.

Agenta programu , zamiast, odwzorowuje każdą możliwą Percept do działania.

Używamy terminu „percepcja” w odniesieniu do percepcyjnych wejść sprawcy w danym momencie. Na poniższych rysunkach agentem jest wszystko, co można postrzegać jako postrzegające swoje otoczenie za pomocą czujników i działające na to środowisko za pomocą siłowników.

Aplikacje

Inteligentni agenci są wykorzystywani jako zautomatyzowani asystenci online , gdzie funkcjonują w celu dostrzegania potrzeb klientów w celu zindywidualizowanej obsługi klienta . Taki agent może zasadniczo składać się z systemu dialogowego , awatara , a także systemu eksperckiego, który zapewnia użytkownikowi określoną wiedzę. Mogą być również wykorzystywane do optymalizacji koordynacji grup ludzkich online. Hallerbacha i in. omówiono zastosowanie podejść opartych na agentach do rozwoju i walidacji zautomatyzowanych systemów jazdy za pomocą cyfrowego bliźniaka testowanego pojazdu i mikroskopowej symulacji ruchu opartej na niezależnych agentach. Waymo stworzyło wieloagentowe środowisko symulacyjne Carcraft do testowania algorytmów dla samojezdnych samochodów . Symuluje interakcje drogowe między kierowcami, pieszymi i pojazdami zautomatyzowanymi. Zachowanie ludzi jest imitowane przez sztuczne czynniki oparte na danych o prawdziwym ludzkim zachowaniu. Podstawowa idea wykorzystania modelowania agentowego do zrozumienia autonomicznych samochodów została omówiona już w 2003 roku.

Alternatywne definicje i zastosowania

„Inteligentny agent” jest również często używany jako niejasny termin marketingowy, czasem synonimem „ wirtualnego osobistego asystenta ”. Niektóre XX-wieczne definicje charakteryzują agenta jako program, który pomaga użytkownikowi lub działa w imieniu użytkownika. Te przykłady są znane jako agenci oprogramowania , a czasami „inteligentny agent oprogramowania” (czyli agent oprogramowania z inteligencją) jest określany jako „inteligentny agent”.

Według Nikoli Kasabova systemy IA powinny wykazywać następujące cechy:

- Stopniowe dostosowywanie nowych reguł rozwiązywania problemów

- Dostosuj online i w czasie rzeczywistym

- Potrafią analizować siebie pod kątem zachowania, błędu i sukcesu.

- Uczyć się i doskonalić poprzez interakcję z otoczeniem ( ucieleśnienie )

- Ucz się szybko z dużych ilości danych

- Korzystaj z przykładowych możliwości przechowywania i pobierania danych w oparciu o pamięć

- Mieć parametry do reprezentowania pamięci krótko- i długoterminowej, wieku, zapominania itp.

Zobacz też

- Agent oprogramowania

- Architektury kognitywne

- Radio kognitywne – praktyczne pole do wdrożenia

- Cybernetyka , Informatyka

- Agent eksploracji danych

- Ucieleśniony agent

- Wyszukiwanie sfederowane – możliwość przeszukiwania przez agentów heterogenicznych źródeł danych przy użyciu jednego słownika

- Agenty rozmyte – IA zaimplementowana z adaptacyjną logiką rozmytą

- Język programowania agenta GOAL

- Inteligencja

- Inteligentny system

- Inteligentni agenci JACK

- System wieloagentowy i system wieloagentowy – wielu interaktywnych agentów

- Klasyfikacja PEAS środowiska agenta

- Nauka wzmacniania

- Semantic Web – udostępnianie danych w sieci do automatycznego przetwarzania przez agentów

- Symulowana rzeczywistość

- Symulacja społeczna

- Era inteligentnych agentów

Uwagi

Referencje w tekście

Inne referencje

- Domingos, Pedro (22 września 2015). Główny algorytm: jak poszukiwanie ostatecznej maszyny uczącej zmieni nasz świat . Książki podstawowe . Numer ISBN 978-0465065707.

- Russell, Stuart J .; Norvig, Piotr (2003). Sztuczna inteligencja: nowoczesne podejście (wyd. 2). Upper Saddle River, New Jersey: Prentice Hall. Rozdział 2. ISBN 0-13-790395-2.

- Kasabov, N. (1998). „Wprowadzenie: Hybrydowe inteligentne systemy adaptacyjne”. Międzynarodowy Dziennik Inteligentnych Systemów . 13 (6): 453–454. doi : 10.1002/(SICI)1098-111X(199806)13:6<453::AID-INT1>3.0.CO;2-K .

- Weiss, G. (2013). Systemy wieloagentowe (wyd. 2). Cambridge, MA: MIT Press. Numer ISBN 978-0-262-01889-0.