OpenAI - OpenAI

Współrzędne : 37,7623°N 122.4148°W 37 ° 45′44 "N 122 ° 24′53" W /

| Przemysł | Sztuczna inteligencja |

|---|---|

| Założony | 11 grudnia 2015 r |

| Założyciele |

|

| Siedziba | Pioneer Building, San Francisco , Kalifornia, USA |

Kluczowi ludzie |

|

| Produkty | DALL-E , GPT-3 , GPT-2 , siłownia OpenAI |

Liczba pracowników |

>120 (stan na 2020 r.) |

| Strona internetowa | openai |

| ||

|---|---|---|

|

Firmy

Związane z

|

||

OpenAI to laboratorium badawcze sztucznej inteligencji (AI) składające się z korporacji nastawionej na zysk OpenAI LP i jej spółki macierzystej , non-profit OpenAI Inc. Firma, uważana za konkurenta DeepMind , prowadzi badania w dziedzinie AI z podanym celem promowania i rozwijania przyjaznej sztucznej inteligencji w sposób korzystny dla całej ludzkości. Organizacja została założona w San Francisco pod koniec 2015 roku przez Elona Muska , Sama Altmana i innych, którzy wspólnie zobowiązali się do 1 miliarda dolarów. Musk zrezygnował z zarządu w lutym 2018 roku, ale pozostał darczyńcą. W 2019 roku OpenAI LP otrzymał od Microsoftu inwestycję w wysokości 1 miliarda dolarów .

Historia

W październiku 2015, Elon Musk , Sam Altman i inni inwestorzy ogłosił powstanie OpenAI i zastawione przez US $ mld 1 do przedsięwzięcia. Organizacja oświadczyła, że będzie „swobodnie współpracować” z innymi instytucjami i badaczami, udostępniając swoje patenty i badania opinii publicznej.

27 kwietnia 2016 r. OpenAI wydało publiczną wersję beta „OpenAI Gym”, platformy do badań nad uczeniem się .

5 grudnia 2016 r. OpenAI wydał Universe, platformę programową do pomiaru i szkolenia ogólnej inteligencji sztucznej inteligencji w zakresie gier, stron internetowych i innych aplikacji na całym świecie.

21 lutego 2018 r. Musk zrezygnował ze swojego miejsca w zarządzie, powołując się na „potencjalny przyszły konflikt (interesów)” z rozwojem Tesli AI dla samochodów autonomicznych , ale pozostał darczyńcą.

W 2019 r. OpenAI przeszło z organizacji non-profit do for-profit. Firma przekazała kapitał swoim pracownikom i nawiązała współpracę z firmą Microsoft Corporation , która ogłosiła pakiet inwestycyjny w wysokości 1 miliarda USD do firmy. OpenAI ogłosił następnie zamiar komercyjnego licencjonowania swoich technologii, z Microsoft jako preferowanym partnerem.

Od 2020 roku OpenAI ma siedzibę w Mission District w San Francisco i dzieli dawny budynek Pioneer Trunk Factory z Neuralink , inną firmą założoną przez Muska.

W czerwcu 2020 r. OpenAI ogłosiło GPT-3 , model języka wyszkolony na bilionach słów z Internetu. Ogłoszono również, że powiązany z nim interfejs API , nazwany po prostu „API”, będzie stanowić serce jej pierwszego komercyjnego produktu. GPT-3 ma na celu odpowiadanie na pytania w języku naturalnym, ale może również tłumaczyć między językami i spójnie generować improwizowany tekst.

Uczestnicy

- CEO: Sam Altman , były prezes akceleratora startupów Y Combinator

- Ilya Sutskever , dyrektor ds. badań, były ekspert Google ds. uczenia maszynowego

- CTO: Greg Brockman, były CTO, 3. pracownik Stripe

Inni sponsorzy projektu to:

- Reid Hoffman , współzałożyciel LinkedIn

- Peter Thiel , współzałożyciel PayPal

- Jessica Livingston , założycielka Y Combinator

Firmy:

- Infosys , jedna z indyjskich firm IT

- Dział usług w chmurze firmy Microsoft

Grupa rozpoczęła działalność na początku stycznia 2016 roku z dziewięcioma badaczami. Według Wired Brockman spotkał się z Yoshuą Bengio , jednym z „ojców założycieli” ruchu głębokiego uczenia się , i sporządził listę „najlepszych badaczy w tej dziedzinie”. Peter Lee z Microsoftu stwierdził, że koszt czołowego badacza AI przewyższa koszt najlepszego kandydata na rozgrywającego NFL . Chociaż OpenAI wypłaca pensje na poziomie korporacyjnym (a nie na poziomie non-profit), obecnie nie wypłaca badaczom AI wynagrodzeń porównywalnych z tymi z Facebooka lub Google. Niemniej jednak Sutskever stwierdził, że jest skłonny odejść z Google dla OpenAI „częściowo z powodu bardzo silnej grupy ludzi, a w bardzo dużym stopniu z powodu jego misji”. Brockman stwierdził, że „najlepszą rzeczą, jaką mogłem sobie wyobrazić, było przybliżenie ludzkości do budowania prawdziwej sztucznej inteligencji w bezpieczny sposób”. Badacz OpenAI Wojciech Zaremba stwierdził, że odrzucił „zwariowane na pograniczu” oferty dwu- lub trzykrotnie przekraczające jego wartość rynkową, aby zamiast tego dołączyć do OpenAI.

Motywy

Niektórzy naukowcy, tacy jak Stephen Hawking i Stuart Russell , wyrazili obawy, że jeśli pewnego dnia zaawansowana sztuczna inteligencja zyska zdolność do przeprojektowywania się w coraz szybszym tempie, niepowstrzymana „ eksplozja inteligencji ” może doprowadzić do wyginięcia człowieka . Musk charakteryzuje sztuczną inteligencję jako „największe zagrożenie egzystencjalne ludzkości”. Założyciele OpenAI zorganizowali ją jako organizację non-profit, aby móc skupić swoje badania na tworzeniu pozytywnego długoterminowego wpływu na człowieka.

Musk i Altman stwierdzili, że motywują ich częściowo obawy o ryzyko egzystencjalne, jakie stwarza sztuczna inteligencja ogólna . OpenAI stwierdza, że „trudno pojąć, ile AI na poziomie ludzkim może przynieść społeczeństwu korzyści” i że równie trudno jest zrozumieć „jak bardzo może zaszkodzić społeczeństwu, jeśli zostanie zbudowana lub użyta niewłaściwie”. Badania nad bezpieczeństwem nie mogą być bezpiecznie odkładane: „ze względu na zaskakującą historię sztucznej inteligencji trudno przewidzieć, kiedy sztuczna inteligencja na poziomie człowieka może znaleźć się w zasięgu”. OpenAI stwierdza, że sztuczna inteligencja „powinna być przedłużeniem indywidualnej woli człowieka i, w duchu wolności, tak szeroko i równomiernie rozłożona, jak to tylko możliwe…”, i która to opinia została wyrażona gdzie indziej w odniesieniu do potencjalnie ogromnej klasy AI- włączone produkty: „Czy naprawdę chcemy pozwolić, aby nasze społeczeństwo zostało zinfiltrowane przez autonomicznych agentów oprogramowania i sprzętu, których szczegóły działania są znane tylko nielicznym wybranym? Oczywiście, że nie”. Współprzewodniczący Sam Altman spodziewa się, że trwający od dziesięcioleci projekt przewyższy ludzką inteligencję.

Vishal Sikka , były dyrektor generalny Infosys , stwierdził, że „otwartość”, w ramach której przedsięwzięcie „przyniesie rezultaty ogólnie w większym interesie ludzkości”, jest podstawowym wymogiem jego wsparcia, oraz że OpenAI „bardzo dobrze wpisuje się w nasze od dawna utrzymywane wartości " i ich "staranie się o celową pracę". Cade Metz z Wired sugeruje, że korporacje takie jak Amazon mogą być motywowane chęcią wykorzystania oprogramowania i danych typu open source do wyrównania szans z takimi korporacjami jak Google i Facebook, które posiadają ogromne zasoby zastrzeżonych danych. Altman twierdzi, że firmy Y Combinator będą udostępniać swoje dane OpenAI.

W 2019 roku OpenAI stał się spółką nastawioną na zysk o nazwie OpenAI LP, aby zapewnić dodatkowe finansowanie, pozostając pod kontrolą organizacji non-profit o nazwie OpenAI Inc w strukturze, którą OpenAI nazywa „capped-profit”, będąc wcześniej 501(c)(3) organizacja non-profit .

Strategia

Musk zadał pytanie: „co jest najlepszą rzeczą, jaką możemy zrobić, aby zapewnić dobrą przyszłość? Moglibyśmy siedzieć z boku lub zachęcać do nadzoru regulacyjnego, lub moglibyśmy uczestniczyć w odpowiedniej strukturze z ludźmi, którym zależy na rozwoju AI w sposób bezpieczny i korzystny dla ludzkości”. Musk przyznał, że „zawsze istnieje pewne ryzyko, że faktycznie próbując rozwijać (przyjazną) sztuczną inteligencję, możemy stworzyć coś, o co się martwimy”; niemniej jednak najlepszą obroną jest „umożliwienie jak największej liczbie osób posiadania AI. Jeśli każdy ma moc AI, to nie ma jednej osoby ani małej grupy osób, które mogą mieć supermoc AI”.

Strategia Muska i Altmana wbrew intuicji, polegająca na próbie zmniejszenia ryzyka, że sztuczna inteligencja spowoduje ogólne szkody, poprzez dawanie AI wszystkim, jest kontrowersyjna wśród tych, którzy są zaniepokojeni ryzykiem egzystencjalnym ze strony sztucznej inteligencji . Filozof Nick Bostrom jest sceptyczny wobec podejścia Muska: „Jeśli masz przycisk, który może wyrządzić światu złe rzeczy, nie chcesz go dawać wszystkim”. Podczas rozmowy na temat technologicznej osobliwości w 2016 r. Altman powiedział, że „nie planujemy opublikować całego naszego kodu źródłowego” i wspomniał o planie „umożliwienia szerokiemu połaciowi świata wyboru przedstawicieli do nowego zarządu”. Greg Brockman stwierdził, że „Naszym celem w tej chwili… jest zrobienie najlepszej rzeczy, jaką można zrobić. To trochę niejasne”.

I odwrotnie, początkowa decyzja OpenAI o wstrzymaniu GPT-2 z powodu chęci „pomyłki po stronie ostrożności” w obecności potencjalnego nadużycia została skrytykowana przez zwolenników otwartości. Delip Rao, ekspert w dziedzinie generowania tekstów, stwierdził: „Nie sądzę, aby [OpenAI] spędził wystarczająco dużo czasu, aby udowodnić, że [GPT-2] jest rzeczywiście niebezpieczny”. Inni krytycy argumentowali, że otwarta publikacja jest konieczna, aby powtórzyć badania i móc wymyślić środki zaradcze.

W roku podatkowym 2017 OpenAI wydał 7,9 mln USD, czyli jedną czwartą swoich wydatków funkcjonalnych, na samą chmurę obliczeniową. Dla porównania, całkowite wydatki DeepMind w 2017 roku były znacznie większe i wyniosły 442 mln USD. Latem 2018 r. samo wyszkolenie botów OpenAI Dota 2 wymagało wypożyczenia 128 000 procesorów i 256 procesorów graficznych od Google na kilka tygodni. Według OpenAI, model ograniczonego zysku przyjęty w marcu 2019 r. pozwala OpenAI LP legalnie przyciągać inwestycje z funduszy venture, a ponadto przyznawać pracownikom udziały w firmie, aby mogli powiedzieć „Idę do otwarcia AI, ale na dłuższą metę nie będzie to niekorzystne dla nas jako rodziny”. Wielu czołowych badaczy pracuje dla Google Brain , DeepMind lub Facebook, Inc. , które oferują opcje na akcje niedostępne dla organizacji non-profit. W czerwcu 2019 roku OpenAI LP pozyskał od Microsoftu miliard dolarów , sumę, którą OpenAI planuje wydać „w ciągu pięciu lat, a być może znacznie szybciej”. Altman stwierdził, że nawet miliard dolarów może okazać się niewystarczający, a laboratorium może ostatecznie potrzebować „więcej kapitału, niż kiedykolwiek zebrała jakakolwiek organizacja non-profit”, aby osiągnąć AGI.

Przejście z organizacji non-profit do firmy o ograniczonym dochodzie było postrzegane ze sceptycyzmem przez Orena Etzioni z non-profit Allen Institute for AI , który zgodził się, że pozyskanie najlepszych naukowców do organizacji non-profit jest trudne, ale stwierdził: „Nie zgadzam się z poglądem, że organizacja non-profit może „nie konkurować” i wskazał na udane niskobudżetowe projekty OpenAI i innych. „Gdyby większe i lepsze fundusze zawsze były lepsze, IBM nadal byłby numerem jeden”. Po przejściu, publiczne ujawnianie wynagrodzeń najlepszych pracowników w OpenAI LP nie jest już wymagane prawnie. Organizacja non-profit, OpenAI Inc., jest jedynym akcjonariuszem kontrolującym OpenAI LP. OpenAI LP, mimo że jest firmą nastawioną na zysk, zachowuje formalną odpowiedzialność powierniczą wobec statutu organizacji non-profit OpenAI's Inc. Większość zarządu OpenAI Inc. ma zakaz posiadania udziałów finansowych w OpenAI LP. Ponadto członkowie mniejszości posiadający udziały w OpenAI LP są pozbawieni niektórych głosów z powodu konfliktu interesów . Niektórzy badacze twierdzili, że przejście OpenAI LP na status for-profit jest niezgodne z twierdzeniami OpenAI, że „demokratyzuje” sztuczną inteligencję. Dziennikarz z Vice News napisał, że „ogólnie nigdy nie byliśmy w stanie polegać na inwestorach venture capital, aby poprawić ludzkość”.

Produkty i aplikacje

Badania OpenAI koncentrują się na uczeniu się przez wzmacnianie . OpenAI jest postrzegany jako ważny konkurent DeepMind.

siłownia

Siłownia ma na celu zapewnienie łatwego do skonfigurowania testu porównawczego ogólnej inteligencji z szeroką gamą różnych środowisk — nieco podobnym, ale szerszym niż ImageNet Large Scale Visual Recognition Challenge, stosowanym w badaniach nad uczeniem nadzorowanym — i ma na celu ujednolicenie sposobu w których środowiska są zdefiniowane w publikacjach naukowych dotyczących sztucznej inteligencji, dzięki czemu opublikowane badania stają się łatwiej odtwarzalne. Projekt obiecuje zapewnić użytkownikowi prosty interfejs. Od czerwca 2017 r. Gym może być używany tylko z Pythonem . Od września 2017 r. strona dokumentacji Gym nie była utrzymywana, a aktywne prace koncentrowały się zamiast tego na stronie GitHub .

RoboSumo

W „RoboSumo” wirtualnym humanoidalnym „ metauczeniu ” robotom początkowo brakuje wiedzy o tym, jak nawet chodzić, i biorąc pod uwagę cele uczenia się poruszania się i wypychania przeciwnika z ringu. Dzięki temu przeciwstawnemu procesowi uczenia się agenci uczą się dostosowywać do zmieniających się warunków; gdy agent jest następnie usuwany z tego wirtualnego środowiska i umieszczany w nowym wirtualnym środowisku z silnymi wiatrami, agent przygotowuje się, by pozostać w pozycji pionowej, sugerując, że nauczył się balansować w uogólniony sposób. Igor Mordatch z OpenAI przekonuje, że rywalizacja między agentami może stworzyć „wyścig zbrojeń” inteligencji, który może zwiększyć zdolność agenta do funkcjonowania, nawet poza kontekstem konkurencji.

Gra Debata

W 2018 r. OpenAI uruchomiło grę debatową, która uczy maszyny dyskutować o problemach z zabawkami przed ludzkim sędzią. Celem jest zbadanie, czy takie podejście może pomóc w kontroli decyzji dotyczących sztucznej inteligencji oraz w opracowaniu możliwej do wyjaśnienia sztucznej inteligencji .

Daktyl

Dactyl wykorzystuje uczenie maszynowe do trenowania robota Shadow Hand od podstaw, przy użyciu tego samego kodu algorytmu uczenia wzmacniającego, którego używa OpenAI Five . Ręka robota jest całkowicie przeszkolona w fizycznie niedokładnej symulacji.

Modele generatywne

GPT

Oryginalny papier na generatywnej wstępnego szkolenia (GPT) modelu językowego został napisany przez Alec Radford i współpracowników, a opublikowane w preprintu na stronie OpenAI w dniu 11 czerwca 2018. To pokazało, jak generatywnego modelu języka jest w stanie nabyć światowej wiedzy i przetwarzaj długodystansowe zależności poprzez wstępne szkolenie na zróżnicowanym korpusie z długimi odcinkami ciągłego tekstu.

GPT-2

Generative Pre-trained Transformer 2, powszechnie znany pod skróconą formą GPT-2, to nienadzorowany model języka transformatora i następca GPT. GPT-2 został po raz pierwszy ogłoszony w lutym 2019 r., a tylko ograniczone wersje demonstracyjne zostały początkowo udostępnione publicznie. Pełna wersja GPT-2 nie została natychmiast wydana z obawy o potencjalne nadużycia, w tym aplikacje do pisania fałszywych wiadomości . Niektórzy eksperci wyrażali sceptycyzm, że GPT-2 stanowi poważne zagrożenie. Allen Institute for Artificial Intelligence odpowiedział na GPT-2 z narzędziem do wykrywania fałszywych wiadomości „nerwową”. Inni badacze, tacy jak Jeremy Howard, ostrzegali przed „technologią, która całkowicie wypełnia Twittera, pocztę elektroniczną i sieć rozsądnie brzmiącą, adekwatną do kontekstu prozą, która zagłusza wszelką inną mowę i nie da się jej przefiltrować”. W listopadzie 2019 OpenAI wydało pełną wersję modelu językowego GPT-2. Kilka stron internetowych udostępnia interaktywne demonstracje różnych wystąpień GPT-2 i innych modeli transformatorów.

Autorzy GPT-2 argumentują, że nienadzorowane modele językowe są uczniami ogólnego przeznaczenia, czego ilustracją jest osiągnięcie przez GPT-2 najwyższej dokładności i zakłopotania w 7 z 8 zadań zerowych (tj. model nie był dalej szkolony w żadnym zadaniu specyficzne przykłady wejścia-wyjścia). Korpus, na którym został przeszkolony, zwany WebText, zawiera nieco ponad 8 milionów dokumentów, co daje łącznie 40 GB tekstu z adresów URL udostępnionych w zgłoszeniach Reddit z co najmniej 3 głosami za. Pozwala uniknąć pewnych problemów z kodowaniem słownictwa za pomocą tokenów słów przy użyciu kodowania par bajtów . Pozwala to reprezentować dowolny ciąg znaków poprzez kodowanie zarówno pojedynczych znaków, jak i wieloznakowych tokenów.

GPT-3

Generative Pre-trained Transformer 3, powszechnie znany pod skróconą formą GPT-3 , jest nienadzorowanym modelem językowym Transformera i następcą GPT-2 . Został po raz pierwszy opisany w maju 2020 r. OpenAI stwierdził, że pełna wersja GPT-3 zawiera 175 miliardów parametrów , o dwa rzędy wielkości większe niż 1,5 miliarda parametrów w pełnej wersji GPT-2 (chociaż modele GPT-3 mają zaledwie Przeszkolono także 125 milionów parametrów).

OpenAI stwierdził, że uda GPT-3 w pewnych „ meta-uczenia się zadania”. Może uogólniać cel pojedynczej pary wejście-wyjście . W artykule podano przykład nauczania przekładu i transferu międzyjęzykowego między językiem angielskim i rumuńskim oraz między językiem angielskim i niemieckim.

GPT-3 znacznie poprawił wyniki testów porównawczych w porównaniu z GPT-2. OpenAI ostrzegło, że takie skalowanie modeli językowych może zbliżać się lub napotykać na podstawowe ograniczenia możliwości predykcyjnych modeli językowych. Wstępne szkolenie GPT-3 wymagało kilku tysięcy petaflopów/s-dni obliczeń, w porównaniu z dziesiątkami petaflop/s-dni dla pełnego modelu GPT-2. Podobnie jak w przypadku swojego poprzednika, w pełni wyszkolony model GPT-3 nie został natychmiast udostępniony opinii publicznej ze względu na możliwe nadużycia, chociaż OpenAI planował umożliwić dostęp za pośrednictwem płatnego interfejsu API chmury po dwumiesięcznej bezpłatnej prywatnej wersji beta, która rozpoczęła się w czerwcu 2020 r. .

23 września 2020 r. GPT-3 został licencjonowany wyłącznie przez firmę Microsoft.

Muzyka

MuseNet (2019) firmy OpenAI to głęboka sieć neuronowa wytrenowana do przewidywania kolejnych nut w plikach muzycznych MIDI . Może generować utwory z dziesięcioma różnymi instrumentami w piętnastu różnych stylach. Według The Verge piosenka generowana przez MuseNet zwykle zaczyna się rozsądnie, ale im dłużej jest odtwarzana, popada w chaos.

Jukebox firmy OpenAI (2020) to algorytm o otwartym kodzie źródłowym do generowania muzyki z wokalem. Po przeszkoleniu na 1,2 miliona próbek system akceptuje gatunek, wykonawcę i fragment tekstu, a następnie wyświetla próbki utworów. OpenAI stwierdziło, że piosenki „pokazują lokalną muzyczną spójność, podążają za tradycyjnymi wzorcami akordów”, ale przyznały, że w utworach brakuje „znajomych większych struktur muzycznych, takich jak powtarzające się refreny” i że „istnieje znacząca luka” między Jukebox a muzyką stworzoną przez ludzi. The Verge stwierdził: „To imponujące pod względem technologicznym, nawet jeśli wyniki brzmią jak papkowate wersje piosenek, które mogą wydawać się znajome”, podczas gdy Business Insider stwierdził: „o dziwo, niektóre z powstałych utworów są chwytliwe i brzmią legalnie”.

API

W czerwcu 2020 r. OpenAI ogłosił wielofunkcyjny interfejs API, który, jak powiedział , służy do „dostępu do nowych modeli AI opracowanych przez OpenAI”, aby umożliwić programistom wywołanie „dowolnego zadania AI w języku angielskim”.

DALL-E i CLIP

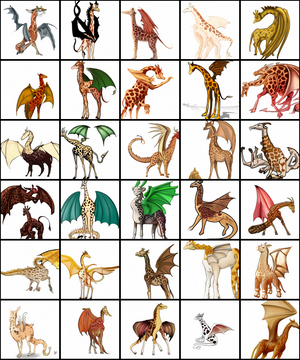

DALL-E to model Transformer, który tworzy obrazy z opisów tekstowych, ujawnionych przez OpenAI w styczniu 2021 roku.

CLIP działa na odwrót: tworzy opis dla danego obrazu. DALL-E wykorzystuje 12-miliardową wersję GPT-3 do interpretacji danych wejściowych w języku naturalnym (takich jak „zielona skórzana torebka w kształcie pięciokąta” lub „widok izometryczny smutnej kapibary”) i generowanie odpowiednich obrazów. Potrafi tworzyć obrazy przedmiotów realistycznych („witraż z wizerunkiem niebieskiej truskawki”) jak i nieistniejących w rzeczywistości („kostka o fakturze jeżozwierza”). Od marca 2021 r. nie jest dostępny żaden interfejs API ani kod.

W marcu 2021 r. OpenAI opublikował artykuł zatytułowany Multimodal Neurons in Artificial Neural Networks , w którym przedstawił szczegółową analizę modeli CLIP (i GPT) oraz ich podatności. W pracy opisano nowy rodzaj ataków na takie modele.

Nazywamy te ataki atakami typograficznymi. Uważamy, że ataki takie jak te opisane powyżej są dalekie od zwykłego problemu akademickiego. Wykorzystując zdolność modelu do dokładnego czytania tekstu, okazuje się, że nawet fotografie odręcznego tekstu mogą często oszukać model.

— Neurony multimodalne w sztucznych sieciach neuronowych , OpenAI

Mikroskop

Mikroskop OpenAI to zbiór wizualizacji każdej znaczącej warstwy i neuronu ośmiu różnych modeli sieci neuronowych, które są często badane pod kątem interpretacji. Mikroskop został stworzony w celu łatwej analizy cech, które tworzą się wewnątrz tych sieci neuronowych. Modele zawarte są AlexNet , VGG 19, różne wersje Incepcja , a różne wersje klipu Resnet .

Boty gier wideo i testy porównawcze

OpenAI Five

OpenAI Five to nazwa zespołu pięciu wyselekcjonowanych przez OpenAI botów używanych w konkurencyjnej grze wideo „pięć na pięć” Dota 2 , które uczą się grać przeciwko ludzkim graczom na wysokim poziomie umiejętności, całkowicie dzięki algorytmom prób i błędów . Zanim został pięcioosobową drużyną, pierwsza publiczna demonstracja odbyła się na The International 2017 , corocznym turnieju o mistrzostwo tej gry, w którym Dendi , zawodowy gracz z Ukrainy, przegrał z botem w pojedynku 1v1 na żywo . Po meczu CTO Greg Brockman wyjaśnił, że bot uczył się, grając przeciwko sobie przez dwa tygodnie czasu rzeczywistego i że oprogramowanie do nauki było krokiem w kierunku stworzenia oprogramowania, które może obsługiwać złożone zadania, takie jak chirurg. System wykorzystuje formę uczenia się przez wzmacnianie , ponieważ boty uczą się z biegiem czasu, grając przeciwko sobie setki razy dziennie przez miesiące i są nagradzane za działania, takie jak zabicie wroga i zdobycie celów na mapie.

Do czerwca 2018 r. możliwości botów rozszerzyły się, aby grać razem jako pełny pięcioosobowy zespół i były w stanie pokonać drużyny amatorów i półprofesjonalnych graczy. Na The International 2018 OpenAI Five grał w dwóch meczach pokazowych przeciwko profesjonalnym graczom, ale ostatecznie przegrał oba mecze. W kwietniu 2019 OpenAI Five pokonało OG , ówczesnych mistrzów świata gry, 2:0 w meczu pokazowym na żywo w San Francisco. Ostateczne publiczne pojawienie się botów nastąpiło później w tym samym miesiącu, kiedy rozegrały one łącznie 42 729 gier w czterodniowym otwartym konkursie online, wygrywając 99,4% tych gier.

SIŁOWNIA Retro

Gym Retro to platforma do badań uczenia się przez wzmacnianie w grach. Gym Retro służy do prowadzenia badań nad algorytmami RL i uogólniania badań. Wcześniejsze badania w RL skupiały się głównie na optymalizacji agentów do rozwiązywania pojedynczych zadań. Gym Retro daje możliwość generalizowania między grami o podobnych koncepcjach, ale różnych wyglądach.