Dopasowanie - Overfitting

W statystyce nadmierne dopasowanie to „tworzenie analizy, która odpowiada zbyt ściśle lub dokładnie określonemu zestawowi danych, a zatem może nie pasować do dodatkowych danych lub niezawodnie przewidywać przyszłe obserwacje”. Overfitted modelem jest model statystyczny , który zawiera więcej parametrów niż można uzasadnić danych. Istotą overfittingu jest nieświadome wyodrębnienie części zmienności szczątkowej (tj. szumu ), tak jakby ta zmienność reprezentowała podstawową strukturę modelu.

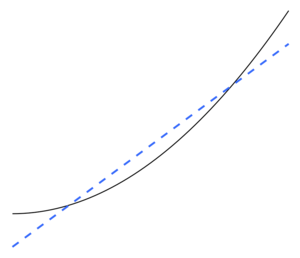

Niedopasowanie występuje, gdy model statystyczny nie jest w stanie odpowiednio uchwycić podstawowej struktury danych. Modelu niedostatecznie wyposażona jest model, w którym niektóre parametry lub warunki, które pojawiają się w prawidłowo określonym modelu brakuje. Niedopasowanie może wystąpić na przykład podczas dopasowywania modelu liniowego do danych nieliniowych. Taki model będzie miał słabą wydajność predykcyjną.

Istnieje możliwość nadmiernego dopasowania, ponieważ kryterium stosowane do wyboru modelu nie jest tym samym, co kryterium stosowane do oceny przydatności modelu. Na przykład model można wybrać, maksymalizując jego wydajność na pewnym zestawie danych uczących , a jednak jego przydatność może być określona przez jego zdolność do dobrego działania na niewidocznych danych; wtedy nadmierne dopasowanie ma miejsce, gdy model zaczyna „zapamiętywać” dane treningowe, a nie „uczyć się” uogólniać na podstawie trendu.

Jako skrajny przykład, jeśli liczba parametrów jest taka sama lub większa niż liczba obserwacji, model może doskonale przewidzieć dane treningowe, po prostu zapamiętując dane w całości. (Dla ilustracji, patrz Rysunek 2.) Taki model jednak zazwyczaj zawiedzie poważnie podczas dokonywania prognoz.

Potencjał overfittingu zależy nie tylko od liczby parametrów i danych, ale także od zgodności struktury modelu z kształtem danych oraz wielkości błędu modelu w porównaniu z oczekiwanym poziomem szumu lub błędu w danych. Nawet jeśli dopasowany model nie ma nadmiernej liczby parametrów, należy się spodziewać, że dopasowana relacja będzie działać gorzej na nowym zestawie danych niż na zestawie danych użytym do dopasowania (zjawisko znane czasami jako skurcz ) . W szczególności, wartość współczynnika określenia będą kurczyć się w stosunku do oryginalnych danych.

Aby zmniejszyć prawdopodobieństwo lub ilość overfittingu, dostępnych jest kilka technik (np. porównanie modeli , walidacja krzyżowa , regularyzacja , wczesne zatrzymanie , przycinanie , bayesowskie priory lub dropout ). Podstawą niektórych technik jest albo (1) jawne karanie zbyt skomplikowanych modeli, albo (2) testowanie zdolności modelu do uogólniania poprzez ocenę jego wydajności na zbiorze danych nieużywanych do uczenia, co zakłada przybliżenie typowych niewidocznych danych jakie napotka model.

Wnioskowanie statystyczne

W statystyce wnioskowanie wyciąga się z modelu statystycznego , który został wybrany za pomocą pewnej procedury. Burnham & Anderson, w często cytowanym tekście na temat wyboru modeli, argumentują, że aby uniknąć nadmiernego dopasowania, powinniśmy stosować się do „ zasady skąpstwa ”. Autorzy stwierdzają również, co następuje.

Modele przesadnie dopasowane … są często wolne od błędów w estymatorach parametrów, ale mają niepotrzebnie duże oszacowane (i rzeczywiste) wariancje próbkowania (precyzja estymatorów jest słaba w porównaniu z tym, co można by osiągnąć za pomocą bardziej oszczędnego modelu). Fałszywe efekty leczenia są zwykle identyfikowane, a fałszywe zmienne są uwzględniane w przesadnie dopasowanych modelach. … Najlepszy model aproksymacyjny uzyskuje się poprzez odpowiednie wyważenie błędów niedopasowania i przeuczenia.

Nadmierne dopasowanie jest bardziej prawdopodobne, gdy istnieje niewiele teorii, które mogłyby pokierować analizą, po części dlatego, że wtedy istnieje zwykle duża liczba modeli do wyboru. Książka Model Selection and Model Averaging (2008) przedstawia to w ten sposób.

Mając zestaw danych, możesz zmieścić tysiące modeli za naciśnięciem jednego przycisku, ale jak wybrać najlepszy? Przy tak wielu kandydujących modelach nadmierne dopasowanie jest prawdziwym niebezpieczeństwem. Czy małpa, która napisała Hamleta, jest naprawdę dobrym pisarzem?

Regresja

W analizie regresji często występuje overfitting. Jako skrajny przykład, jeśli istnieje p zmiennych w regresji liniowej z p punktów danych, dopasowana linia może przejść dokładnie przez każdy punkt. W przypadku modeli regresji logistycznej lub modeli proporcjonalnego hazardu Coxa istnieje wiele praktycznych reguł (np. 5–9, 10 i 10–15 — wytyczna dotycząca 10 obserwacji na zmienną niezależną jest znana jako „ zasada 1 na 10 ”). W procesie wyboru modelu regresji średniokwadratowy błąd losowej funkcji regresji można podzielić na losowy szum, błąd aproksymacyjny i wariancję estymaty funkcji regresji. Bias-wariancji kompromis jest często używany do pokonania modele nadmierne dopasowanie.

W przypadku dużego zestawu zmiennych objaśniających, które w rzeczywistości nie mają związku z przewidywaną zmienną zależną , niektóre zmienne zostaną ogólnie błędnie uznane za statystycznie istotne, a badacz może w ten sposób zachować je w modelu, przesadzając w ten sposób z modelem. Jest to znane jako paradoks Freedmana .

Nauczanie maszynowe

Zwykle algorytm uczący jest szkolony przy użyciu pewnego zestawu „danych uczących ”: przykładowych sytuacji, dla których znane są pożądane wyniki. Celem jest, aby algorytm działał również dobrze w przewidywaniu danych wyjściowych po podaniu „danych walidacyjnych”, które nie zostały napotkane podczas jego uczenia.

Overfitting to stosowanie modeli lub procedur, które naruszają brzytwę Ockhama , na przykład poprzez uwzględnienie większej liczby regulowanych parametrów niż są ostatecznie optymalne lub poprzez zastosowanie bardziej skomplikowanego podejścia niż jest to ostatecznie optymalne. Na przykład, gdy istnieje zbyt wiele regulowanych parametrów, rozważ zbiór danych, w którym dane treningowe dla y można odpowiednio przewidzieć za pomocą funkcji liniowej dwóch zmiennych niezależnych. Taka funkcja wymaga tylko trzech parametrów (punkt przecięcia i dwa nachylenia). Zastąpienie tej prostej funkcji nową, bardziej złożoną funkcją kwadratową lub nową, bardziej złożoną funkcją liniową na więcej niż dwóch zmiennych niezależnych, niesie ze sobą ryzyko: brzytwa Ockhama implikuje, że jakakolwiek dana złożona funkcja jest a priori mniej prawdopodobna niż jakakolwiek dana prosta funkcjonować. Jeśli zamiast funkcji prostej zostanie wybrana nowa, bardziej skomplikowana funkcja, a dopasowanie danych uczących nie jest wystarczająco duże, aby zrównoważyć wzrost złożoności, wówczas nowa funkcja złożona „przepełnia” dane, a złożona jest przesadnie dopasowana. funkcja prawdopodobnie będzie działać gorzej niż prostsza funkcja na danych walidacyjnych poza uczącym zbiorem danych, mimo że złożona funkcja działała równie dobrze, a może nawet lepiej, na uczącym zbiorze danych.

Porównując różne typy modeli, złożoności nie można zmierzyć wyłącznie poprzez zliczenie liczby parametrów występujących w każdym modelu; należy również wziąć pod uwagę ekspresję każdego parametru. Na przykład nietrywialne jest bezpośrednie porównanie złożoności sieci neuronowej (która może śledzić relacje krzywoliniowe) z m parametrami z modelem regresji z n parametrami.

Overfitting jest szczególnie prawdopodobny w przypadkach, gdy uczenie było prowadzone zbyt długo lub gdy przykłady uczące są rzadkie, co powoduje, że uczący się dostosowuje się do bardzo specyficznych losowych cech danych uczących, które nie mają związku przyczynowo-skutkowego z funkcją docelową . W tym procesie nadmiernego dopasowania wydajność na przykładach uczących nadal wzrasta, podczas gdy wydajność na niewidocznych danych pogarsza się.

Jako prosty przykład rozważmy bazę danych zakupów detalicznych, która zawiera zakupiony przedmiot, nabywcę oraz datę i godzinę zakupu. Łatwo jest zbudować model, który będzie idealnie pasował do zestawu uczącego, wykorzystując datę i godzinę zakupu do przewidywania innych atrybutów, ale ten model nie będzie w ogóle uogólniał nowych danych, ponieważ te przeszłe czasy już nigdy się nie powtórzą.

Ogólnie mówi się, że algorytm uczący się przesadza w stosunku do prostszego, jeśli jest dokładniejszy w dopasowywaniu znanych danych (wsteczny), ale mniej dokładny w przewidywaniu nowych danych (foresight). Intuicyjnie można zrozumieć nadmierne dopasowanie z faktu, że informacje ze wszystkich przeszłych doświadczeń można podzielić na dwie grupy: informacje istotne dla przyszłości i informacje nieistotne („hałas”). Gdy wszystko inne jest równe, im trudniej jest przewidzieć kryterium (tj. im wyższa jest jego niepewność), tym więcej szumu występuje w informacjach z przeszłości, które należy zignorować. Problem polega na ustaleniu, którą część zignorować. Algorytm uczący się, który może zmniejszyć prawdopodobieństwo dopasowania szumu, nazywa się „ solidnym ”.

Konsekwencje

Najbardziej oczywistą konsekwencją nadmiernego dopasowania jest słaba wydajność zestawu danych walidacyjnych. Inne negatywne konsekwencje to:

- Funkcja, która jest przesadzona, prawdopodobnie zażąda więcej informacji o każdym elemencie w zbiorze danych walidacyjnych niż funkcja optymalna; zebranie tych dodatkowych niepotrzebnych danych może być kosztowne lub podatne na błędy, zwłaszcza jeśli każda pojedyncza informacja musi być zebrana przez ludzką obserwację i ręczne wprowadzanie danych.

- Bardziej złożona, przesadnie wyposażona funkcja prawdopodobnie będzie mniej przenośna niż prosta. Z jednej strony regresja liniowa z jedną zmienną jest tak przenośna, że w razie potrzeby można ją wykonać nawet ręcznie. Na drugim biegunie znajdują się modele, które można odtworzyć tylko poprzez dokładne powielenie całej konfiguracji oryginalnego modelarza, co utrudnia ponowne wykorzystanie lub reprodukcję naukową.

Zaradzić

Optymalna funkcja zwykle wymaga weryfikacji na większych lub zupełnie nowych zestawach danych. Istnieją jednak metody, takie jak minimalne drzewo rozpinające lub czas życia korelacji, które wykorzystują zależność między współczynnikami korelacji a szeregami czasowymi (szerokość okna). Gdy szerokość okna jest wystarczająco duża, współczynniki korelacji są stabilne i nie zależą już od rozmiaru okna. Dlatego macierz korelacji można utworzyć, obliczając współczynnik korelacji między badanymi zmiennymi. Macierz tę można topologicznie przedstawić jako złożoną sieć, w której wizualizowane są bezpośrednie i pośrednie wpływy między zmiennymi.

Niedopasowanie

Niedopasowanie występuje, gdy model statystyczny lub algorytm uczenia maszynowego nie może odpowiednio uchwycić podstawowej struktury danych. Dzieje się tak, gdy model lub algorytm nie jest wystarczająco dopasowany do danych. Niedopasowanie występuje, gdy model lub algorytm wykazuje niską wariancję, ale wysokie obciążenie (dla kontrastu, nadmierne dopasowanie z wysokiej wariancji i niskim odchyleniem). Często jest to wynik zbyt prostego modelu, który nie jest w stanie przetworzyć złożoności problemu (patrz też błąd aproksymacji ). Skutkuje to modelem, który nie jest odpowiedni do obsługi całego sygnału i dlatego jest zmuszony traktować część sygnału jako szum. Jeśli zamiast tego model jest w stanie obsłużyć sygnał, ale i tak bierze jego część jako szum, jest również uważany za niedostosowany. Ten ostatni przypadek może mieć miejsce, jeśli funkcja straty modelu zawiera karę, która w tym konkretnym przypadku jest zbyt wysoka.

Burnham i Anderson stwierdzają, co następuje.

… niedopasowany model zignorowałby pewną ważną powtarzalną (tj. koncepcyjnie powtarzalną w większości innych próbek) strukturę danych, a tym samym nie zidentyfikowałby skutków, które faktycznie były poparte danymi. W tym przypadku błąd systematyczny estymatorów parametrów jest często znaczny, a wariancja próbkowania jest niedoszacowana, co skutkuje słabym pokryciem przedziału ufności. Niedopasowane modele mają tendencję do pomijania ważnych efektów leczenia w warunkach eksperymentalnych.

Zobacz też

- Kompromis między odchyleniami a wariancją

- Dopasowanie krzywej

- Pogłębianie danych

- Wybór funkcji

- Paradoks Freedmana

- Błąd generalizacji

- Dobroć dopasowania

- Czas życia korelacji

- Wybór modelu

- Brzytwa Ockhama

- Model podstawowy

- Wymiar VC – większy wymiar VC oznacza większe ryzyko nadmiernego dopasowania

Uwagi

Bibliografia

- Leinweber, DJ (2007). „Głupie sztuczki eksploratora danych”. Dziennik Inwestowania . 16 :15–22. doi : 10.3905/joi.2007.681820 . S2CID 108627390 .

- Tetko, IV; Livingstone, DJ; Luik, AI (1995). „Badania sieci neuronowych. 1. Porównanie przetrenowania i przetrenowania” (PDF) . Journal of Chemical Information and Modeling . 35 (5): 826-833. doi : 10.1021/ci00027a006 .

- Wskazówka 7: Zminimalizuj nadmierne dopasowanie . Chicco, D. (grudzień 2017). „Dziesięć szybkich wskazówek dotyczących uczenia maszynowego w biologii obliczeniowej” . Eksploracja danych biologicznych . 10 (35): 35. doi : 10.1186/s13040-017-0155-3 . PMC 5721660 . PMID 29234465 .

Dalsza lektura

- Chrześcijanin, Brian ; Griffiths, Tom (kwiecień 2017), "Rozdział 7: Overfitting", Algorytmy do życia: Informatyka ludzkich decyzji , William Collins , s. 149-168, ISBN 978-0-00-754799-9