Studenta t -test -Student's t-test

T -test jakakolwiek próba hipoteza statystyczna , w którym statystyka testowa następuje Studenta t -Dystrybucja pod hipotezy zerowej .

Test t jest najczęściej stosowany, gdy statystyka testowa miałaby rozkład normalny, gdyby znana była wartość składnika skalującego w statystyce testowej. Gdy termin skalowania jest nieznany i zostaje zastąpiony oszacowaniem opartym na danych , statystyki testowe (w pewnych warunkach) są zgodne z rozkładem t Studenta. Test t może być wykorzystany na przykład do określenia, czy średnie z dwóch zestawów danych znacznie się od siebie różnią.

Historia

Termin „statystyka t ” jest skrócony od „statystyka testu hipotez”. W statystyce rozkład t został po raz pierwszy wyprowadzony jako rozkład a posteriori w 1876 roku przez Helmerta i Lürotha . Rozkład t pojawił się również w bardziej ogólnej formie jako rozkład Pearsona typu IV w pracy Karla Pearsona z 1895 roku. Jednak T-Distribution, znana również jako Student's T Distribution, bierze swoją nazwę od Williama Sealy'ego Gosseta, który po raz pierwszy opublikował ją w języku angielskim w 1908 roku w czasopiśmie naukowym Biometrika, używając pseudonimu „Student”, ponieważ jego pracodawca wolał, aby pracownicy używali pseudonimów podczas publikowania. prace naukowe zamiast ich prawdziwego nazwiska, więc użył nazwy „Student”, aby ukryć swoją tożsamość. Gosset pracował w browarze Guinnessa w Dublinie , Irlandia , i był zainteresowany problematyką małych próbek - na przykład, właściwości chemiczne jęczmienia z małymi rozmiarami próbek. Stąd druga wersja etymologii terminu Student że Guinness nie chce ich konkurenci wiedzieć, że były one za pomocą testu t do określenia jakości surowca (patrz Studenta t -Dystrybucja do szczegółowej historii tego pseudonimu, czego nie należy mylić z dosłownym terminem student ). Chociaż to William Gosset został nazwany terminem „Student”, to dzięki pracy Ronalda Fishera dystrybucja stała się dobrze znana jako „Dystrybucja Studenta” i „Test Studenta”.

Gosset został zatrudniony dzięki polityce Claude'a Guinnessa polegającej na rekrutowaniu najlepszych absolwentów z Oksfordu i Cambridge do zastosowania biochemii i statystyki w procesach przemysłowych Guinnessa. Gosset opracował test t jako ekonomiczny sposób monitorowania jakości stouta . Praca t- testu została przedłożona i zaakceptowana w czasopiśmie Biometrika i opublikowana w 1908 roku.

Guinness miał politykę zezwalania personelowi technicznemu na urlop na studia (tzw. „urlop na naukę”), z której Gosset korzystał podczas pierwszych dwóch semestrów roku akademickiego 1906-1907 w Laboratorium Biometrycznym profesora Karla Pearsona w University College London . Tożsamość Gosseta była wtedy znana kolegom statystykom i redaktorowi naczelnemu Karlowi Pearsonowi.

Zastosowania

Wśród najczęściej stosowanych testów t są:

- Jedna próbka testu lokalizacja czy średnia z populacji ma wartość określoną w hipotezie zerowej .

- Dwie próbki testu lokalizacji hipotezy zerowej, tak że środki dwóch populacji są równe. Wszystkie takie testy są zwykle nazywane Studenta t -tests , chociaż ściśle mówiąc nazwa ta powinna być stosowana tylko wtedy, gdy wariancje obu populacjach są również przyjmuje się równe; forma testu używana po odrzuceniu tego założenia jest czasami nazywana testem t Welcha . Testy te są często określane jako testy t dla próbek niesparowanych lub niezależnych , ponieważ są one zwykle stosowane, gdy jednostki statystyczne leżące u podstaw dwóch porównywanych próbek nie nakładają się.

Założenia

Większość statystyk testowych ma postać t = Z/s, gdzie Z i s są funkcjami danych.

Z może być wrażliwe na hipotezę alternatywną (tj. jego wielkość jest zwykle większa, gdy hipoteza alternatywna jest prawdziwa), podczas gdy s jest parametrem skalującym, który umożliwia określenie rozkładu t .

Na przykład w jednopróbkowym teście t

gdzie X to średnia próbki z próbki X 1 , X 2 , …, X n , o rozmiarze n , s to błąd standardowy średniej , to oszacowanie odchylenia standardowego populacji, a μ to średnia populacji .

Założenia leżące u podstaw testu t w najprostszej formie powyżej są następujące:

- X podąża za rozkładem normalnym ze średnią μ i wariancjąσ 2/n

- s 2 ( n − 1)/ σ 2 ma rozkład χ 2 z n − 1 stopniami swobody . Założenie to jest spełnione, gdy obserwacje użyte do oszacowania s 2 pochodzą z rozkładu normalnego (iid dla każdej grupy).

- Z i s są niezależne .

W teście t porównującym średnie z dwóch niezależnych prób należy spełnić następujące założenia:

- Średnie dwóch porównywanych populacji powinny być zgodne z rozkładem normalnym . Przy słabych założeniach wynika to w dużych próbach z centralnego twierdzenia granicznego , nawet jeśli rozkład obserwacji w każdej grupie nie jest normalny.

- W przypadku korzystania z oryginalnego określenia Studenta z t -Test, dwie populacje porównywanych powinien mieć taką samą wariancji (dającej się przetestować pomocą F -test , testu Levene'a , Test Bartletta lub testu Brown-Forsythe lub się oszacować graficznie za pomocą Q-Q wykres ). Jeśli wielkości próbek w dwóch porównywanych grupach są równe, oryginalny test t- Studenta jest wysoce odporny na obecność nierównych wariancji. Welcha t -test jest niewrażliwy na równości wariancji niezależnie od tego, czy próbka rozmiary są podobne.

- Dane użyte do przeprowadzenia testu powinny być pobierane niezależnie od dwóch porównywanych populacji lub być w pełni sparowane. Na ogół nie można tego przetestować na podstawie danych, ale jeśli wiadomo, że dane są zależne (np. sparowane przez projekt testu), należy zastosować test zależny. W przypadku częściowo sparowanych danych klasyczne niezależne testy t mogą dawać nieprawidłowe wyniki, ponieważ statystyka testowa może nie być zgodna z rozkładem t , podczas gdy zależny test t jest suboptymalny, ponieważ odrzuca dane niesparowane.

Większość dwupróbkowych testów t jest odporna na wszystkie, poza dużymi odchyleniami od założeń.

Dla dokładności , test t i test Z wymagają normalności średnich z próby , a test t dodatkowo wymaga , aby wariancja próbki była zgodna ze skalowanym rozkładem χ 2 , a średnia próbki i wariancja próbki były statystycznie niezależne . Normalność poszczególnych wartości danych nie jest wymagana, jeśli te warunki są spełnione. Według centralnego twierdzenia granicznego średnie próby umiarkowanie dużych próbek są często dobrze aproksymowane przez rozkład normalny, nawet jeśli dane nie mają rozkładu normalnego. Dla nie-normalnych danych, rozkład wariancji próby może różnić się znacznie od χ 2 dystrybucji. Jeśli jednak wielkość próby jest duża, twierdzenie Słuckiego implikuje, że rozkład wariancji próby ma niewielki wpływ na rozkład statystyki testowej.

Niesparowane i sparowane dwupróbkowe testy t

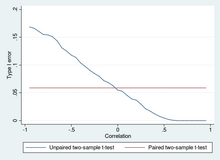

Testy t dla dwóch prób dla różnicy średniej obejmują próbki niezależne (próbki niesparowane) lub próbki sparowane. Sparowane testy t są formą blokowania i mają większą moc (prawdopodobieństwo uniknięcia błędu typu II, znanego również jako fałszywie ujemny) niż testy niesparowane, gdy sparowane jednostki są podobne pod względem „współczynników szumu”, które są niezależne od przynależność do dwóch porównywanych grup. W innym kontekście, sparowane testy t- Studenta mogą być stosowane w celu zmniejszenia wpływu czynników zakłócających w badaniu obserwacyjnym .

Niezależne (niesparowane) próbki

Test t dla niezależnych próbek jest stosowany, gdy otrzymuje się dwa oddzielne zestawy niezależnych i identycznie rozłożonych próbek, po jednym z każdej z dwóch porównywanych populacji. Załóżmy na przykład, że oceniamy efekt leczenia medycznego i włączamy do naszego badania 100 osób, a następnie losowo przypisujemy 50 osób do grupy leczenia i 50 osób do grupy kontrolnej. W tym przypadku mamy dwie niezależne próbki i użylibyśmy niesparowanej postaci testu t .

Sparowane próbki

Sparowanych próbek t -tests składają się zwykle z próbki parami podobnych jednostek , lub jedna grupa urządzeń, które zostały przetestowane dwukrotnie (A „powtarzanych pomiarów” T -test).

Typowym przykładem testu t z powtarzanymi pomiarami byłoby badanie osobników przed leczeniem, na przykład na wysokie ciśnienie krwi, i ponowne badanie tych samych osobników po leczeniu lekiem obniżającym ciśnienie krwi. Porównując te same liczby pacjentów przed i po leczeniu, skutecznie wykorzystujemy każdego pacjenta jako własną kontrolę. W ten sposób prawidłowe odrzucenie hipotezy zerowej (tutaj: brak różnicy w leczeniu) może stać się znacznie bardziej prawdopodobne, przy wzroście mocy statystycznej po prostu dlatego, że losowa zmienność między pacjentami została teraz wyeliminowana. Jednak wzrost mocy statystycznej ma swoją cenę: potrzeba więcej testów, a każdy przedmiot musi zostać przetestowany dwukrotnie. Ponieważ połowa próbki zależy teraz od drugiej połowy, sparowana wersja testu t- Studenta ma tylkon/2− 1 stopień swobody (gdzie n to całkowita liczba obserwacji). Pary stają się indywidualnymi jednostkami testowymi, a próbka musi zostać podwojona, aby osiągnąć tę samą liczbę stopni swobody. Zwykle istnieje n − 1 stopni swobody (gdzie n to całkowita liczba obserwacji).

Test t dla sparowanych próbek oparty na „próbce z dopasowanymi parami” wynika z niesparowanej próbki, która jest następnie używana do utworzenia sparowanej próbki, przy użyciu dodatkowych zmiennych, które zostały zmierzone wraz ze zmienną będącą przedmiotem zainteresowania. Dopasowanie odbywa się poprzez identyfikację par wartości składających się z jednej obserwacji z każdej z dwóch próbek, gdzie para jest podobna pod względem innych mierzonych zmiennych. Takie podejście jest czasami stosowane w badaniach obserwacyjnych w celu zmniejszenia lub wyeliminowania skutków czynników zakłócających.

Testy t dla sparowanych próbek są często określane jako „ testy t dla prób zależnych”.

Obliczenia

Jawne wyrażenia, które mogą być użyte do przeprowadzenia różnych testów t są podane poniżej. W każdym przypadku podany jest wzór na statystykę testową, która albo dokładnie podąża za rozkładem t- Studentów w ramach hipotezy zerowej, albo ściśle go przybliża . W każdym przypadku podane są również odpowiednie stopnie swobody . Każdą z tych statystyk można wykorzystać do przeprowadzenia testu jednostronnego lub dwustronnego .

Po określeniu wartości t i stopni swobody, wartość p można znaleźć za pomocą tabeli wartości z rozkładu t- Studenta . Jeżeli obliczona wartość p jest poniżej progu wybranego dla istotności statystycznej (zazwyczaj poziom 0,10, 0,05 lub 0,01), wówczas hipoteza zerowa jest odrzucana na rzecz hipotezy alternatywnej.

Jedną próbkę t -test

Testując hipotezę zerową, że średnia populacji jest równa określonej wartości μ 0 , stosuje się statystykę

gdzie to średnia próbki, s to odchylenie standardowe próbki, a n to wielkość próby. Stopnie swobody użyte w tym teście to n − 1 . Chociaż populacja rodzicielska nie musi mieć rozkładu normalnego, zakłada się , że rozkład populacji średnich z próby jest normalny.

Według centralnego twierdzenia granicznego , jeśli obserwacje są niezależne i drugi moment istnieje, to będzie w przybliżeniu normalny N(0;1).

Nachylenie linii regresji

Załóżmy, że ktoś pasuje do modelu

gdzie x jest znane, α i β są nieznane, ε jest zmienną losową o rozkładzie normalnym ze średnią 0 i nieznaną wariancją σ 2 , a Y jest wynikiem zainteresowania. Chcemy przetestować hipotezę zerową, że nachylenie β jest równe pewnej określonej wartości β 0 (często przyjmowanej jako 0, w którym to przypadku hipoteza zerowa mówi, że x i y są nieskorelowane).

Pozwolić

Następnie

ma rozkład t z n − 2 stopniami swobody, jeśli hipoteza zerowa jest prawdziwa. Błędu standardowego współczynnika nachylenia :

można zapisać w postaci reszt. Pozwolić

Wtedy t- score określa się wzorem :

Innym sposobem określania t wynik to:

gdzie r jest współczynnikiem korelacji Pearsona .

Wynik t, punkt przecięcia można określić na podstawie wyniku t , nachylenie :

gdzie s x 2 jest wariancją próbki.

Niezależny dwupróbkowy test t

Równe wielkości próbek i wariancja

Biorąc pod uwagę dwie grupy (1, 2), test ten ma zastosowanie tylko wtedy, gdy:

- dwie wielkości próby (tj. liczba n uczestników każdej grupy) są równe;

- można założyć, że oba rozkłady mają tę samą wariancję;

Naruszenia tych założeń omówiono poniżej.

T statystyczne stwierdzenia, czy są różne środki można obliczyć w następujący sposób:

gdzie

Tutaj s p jest zbiorczym odchyleniem standardowym dla n = n 1 = n 2 i s 2

x 1oraz s 2

X 2są bezstronne estymatory tych różnic tych dwóch próbek. Mianownikiem t jest błąd standardowy różnicy między dwiema średnimi.

W przypadku testowania istotności stopnie swobody dla tego testu wynoszą 2 n − 2, gdzie n to liczba uczestników w każdej grupie.

Równe lub nierówne wielkości próby, podobne wariancje (1/2 < s X 1/s X 2 < 2)

Ten test jest używany tylko wtedy, gdy można założyć, że oba rozkłady mają tę samą wariancję. (Kiedy to założenie jest naruszone, patrz poniżej.) Poprzednie formuły są szczególnym przypadkiem poniższych formuł, odzyskuje się je, gdy obie próbki są równe pod względem wielkości: n = n 1 = n 2 .

T statystyczne stwierdzenia, czy są różne środki można obliczyć w następujący sposób:

gdzie

jest estymatorem łącznego odchylenia standardowego dwóch próbek: jest zdefiniowany w ten sposób, że jego kwadrat jest nieobciążonym estymatorem wspólnej wariancji, niezależnie od tego, czy średnie populacji są takie same. We wzorach n i − 1 to liczba stopni swobody dla każdej grupy, a całkowita wielkość próbki minus dwa (czyli n 1 + n 2 − 2 ) to całkowita liczba stopni swobody, która jest używana w testowaniu istotności.

Równe lub nierówne wielkości próby, nierówne wariancje ( s X 1 > 2 s X 2 lub s X 2 > 2 s X 1 )

Test ten, znany również jako test t Welcha , jest używany tylko wtedy, gdy nie zakłada się, że dwie wariancje populacji są równe (dwie wielkości próby mogą być równe lub nie), a zatem muszą być szacowane oddzielnie. T statystyczne stwierdzenia, czy środki populacji różni oblicza się jako:

gdzie

Tutaj s i 2 jest nieobciążony estymator o wariancji każdej z dwóch próbek z n I = liczba osób w grupie i ( i = 1 lub 2). W tym przypadku nie jest to pula wariancji. Do wykorzystania w testowaniu istotności rozkład statystyki testowej jest aproksymowany jako zwykły rozkład t- Studenta ze stopniami swobody obliczonymi za pomocą

Jest to znane jako równanie Welcha-Satterthwaite'a . Prawdziwy rozkład statystyki testowej faktycznie zależy (nieznacznie) od dwóch nieznanych wariancji populacji (patrz problem Behrensa-Fishera ).

Zależny test t dla sparowanych próbek

Ten test jest stosowany, gdy próbki są zależne; to znaczy, gdy tylko jedna próbka została przebadana dwukrotnie (powtarzane pomiary) lub gdy są dwie próbki, które zostały dopasowane lub „sparowane”. To jest przykład testu sparowanych różnic . T statystyczne obliczono jako

gdzie i są średnią i odchyleniem standardowym różnic między wszystkimi parami. Pary to np. wyniki jednej osoby przed i po teście lub między parami osób dobranych do znaczących grup (np. pochodzących z tej samej rodziny lub grupy wiekowej: patrz tabela). Stała μ 0 wynosi zero, jeśli chcemy sprawdzić, czy średnia różnicy jest znacząco różna. Zastosowany stopień swobody to n − 1 , gdzie n reprezentuje liczbę par.

Przykład powtórzonych pomiarów Numer Nazwa Test 1 Test 2 1 Mikrofon 35% 67% 2 Melanie 50% 46% 3 Melisa 90% 86% 4 Mitchell 78% 91%

Przykład dopasowanych par Para Nazwa Wiek Test 1 Jan 35 250 1 Jane 36 340 2 Jimmy 22 460 2 Jessy 21 200

Przepracowane przykłady

Niech A 1 oznacza zbiór otrzymany z losowej próby sześciu pomiarów:

i niech A 2 oznacza drugi zbiór otrzymany podobnie:

Mogą to być np. masy śrub, które zostały wybrane z wiadra.

Przeprowadzimy testy hipotezy zerowej, że średnie populacji, z których pobrano dwie próbki, są równe.

Różnica między dwiema średnimi prób, każda oznaczona przez X i , która pojawia się w liczniku dla wszystkich podejść do testowania dwóch prób omówionych powyżej, jest

Odchylenia standardowe próbki dla dwóch próbek wynoszą odpowiednio około 0,05 i 0,11. W przypadku tak małych próbek test równości między dwiema wariancjami populacji nie byłby zbyt mocny. Ponieważ wielkości próbek są równe, dwie formy dwupróbkowego testu t będą działały podobnie w tym przykładzie.

Nierówne wariancje

Jeśli zastosuje się podejście do nierównych wariancji (omówione powyżej), wyniki są

i stopnie swobody

Statystyka testowa wynosi około 1,959, co daje dwustronną wartość p testu równą 0,09077.

Równe wariancje

Jeśli zastosuje się podejście dla równych wariancji (omówione powyżej), wyniki są

i stopnie swobody

Statystyka testowa jest w przybliżeniu równa 1,959, co daje dwustronną wartość p równą 0,07857.

Powiązane testy statystyczne

Alternatywy dla testu t dla problemów lokalizacyjnych

Test t zapewnia dokładny test równości średnich dwóch normalnych populacji o nieznanych, ale równych wariancjach. ( T -test Welcha jest testem prawie dokładnym dla przypadku, gdy dane są normalne, ale wariancje mogą się różnić.) W przypadku umiarkowanie dużych próbek i testu jednostronnego, test t jest stosunkowo solidny do umiarkowanego naruszenia założenia o normalności. W wystarczająco dużych próbek, test t-Studenta asymptotycznie zbliża się ż -Test i staje się wytrzymałe nawet dużych odchyleń od normalności.

Jeśli dane są zasadniczo nienormalne, a wielkość próbki jest mała, test t może dać mylące wyniki. Zobacz Test lokalizacji dla rozkładów mieszanin w skali Gaussa, aby zapoznać się z pewną teorią związaną z jedną konkretną rodziną rozkładów nienormalnych.

Gdy założenie o normalności nie jest spełnione, nieparametryczna alternatywa dla testu t może mieć lepszą moc statystyczną . Jednakże, gdy dane nie są normalne z różnymi wariancjami między grupami, test t może mieć lepszą kontrolę błędu typu 1 niż niektóre nieparametryczne alternatywy. Ponadto metody nieparametryczne, takie jak test U Manna-Whitneya omówiony poniżej, zazwyczaj nie sprawdzają różnicy średnich, dlatego należy je stosować ostrożnie, jeśli różnica średnich ma podstawowe znaczenie naukowe. Na przykład test U Manna-Whitneya utrzyma błąd typu 1 na pożądanym poziomie alfa, jeśli obie grupy mają ten sam rozkład. Będzie również mieć moc wykrywania alternatywy, według której grupa B ma taki sam rozkład jak A, ale po pewnym przesunięciu o stałą (w takim przypadku rzeczywiście istniałaby różnica w średnich dwóch grup). Mogą jednak wystąpić przypadki, w których grupy A i B będą miały różne rozkłady, ale z tymi samymi średnimi (np. dwa rozkłady, jeden z dodatnią skośnością, a drugi z ujemnym, ale przesunięty tak, aby mieć te same średnie). W takich przypadkach MW może mieć moc większą niż poziom alfa w odrzuceniu hipotezy zerowej, ale przypisywanie interpretacji różnicy średnich takiemu wynikowi byłoby błędne.

W obecności wartości odstającej test t nie jest solidny. Na przykład dla dwóch niezależnych próbek, gdy rozkłady danych są asymetryczne (to znaczy rozkłady są skośne ) lub rozkłady mają duże ogony, test sumy rang Wilcoxona (znany również jako test U Manna-Whitneya ) może mieć trzy do czterokrotnie większej mocy niż test t . Nieparametryczny odpowiednik sparowanych próbek t -test jest badanie podpisana rank Wilcoxona dla par próbek. Aby zapoznać się z dyskusją na temat wyboru między testem- t a alternatywami nieparametrycznymi, patrz Lumley, et al. (2002).

Jednokierunkowa analiza wariancji (ANOVA) uogólnia dwupróbkowy test t, gdy dane należą do więcej niż dwóch grup.

Projekt, który zawiera zarówno obserwacje sparowane, jak i obserwacje niezależne

Gdy w układzie dwóch próbek występują zarówno obserwacje sparowane, jak i obserwacje niezależne, zakładając, że brakuje danych całkowicie losowo (MCAR), obserwacje sparowane lub obserwacje niezależne można odrzucić w celu kontynuowania powyższych testów standardowych. Alternatywnie, wykorzystując wszystkie dostępne dane, zakładając normalność i MCAR, można zastosować uogólniony test t dla częściowo nakładających się próbek.

Testy wielowymiarowe

Uogólnienie statystyki t - Studenta , zwane statystyką t- kwadrat Hotellinga , pozwala na testowanie hipotez na wielu (często skorelowanych) miarach w tej samej próbie. Na przykład, badacz może poddać pewną liczbę osób testowi osobowości składającemu się z wielu skal osobowości (np. Minnesota Multiphasic Personality Inventory ). Ponieważ miary tego typu są zwykle skorelowane dodatnio, nie zaleca się przeprowadzania oddzielnych jednowymiarowych testów t w celu testowania hipotez, ponieważ zaniedbywałyby one kowariancję między miarami i zwiększały prawdopodobieństwo fałszywego odrzucenia co najmniej jednej hipotezy ( błąd typu I ). W takim przypadku do testowania hipotez preferowany jest pojedynczy test wielowymiarowy. Metoda Fishera łączenia wielu testów z obniżoną alfa dla pozytywnej korelacji między testami to jedna. Innym jest hotelingowe za T 2 statystyka następuje T 2 dystrybucję. Jednak w praktyce podział jest rzadko stosowany, ponieważ tabelaryczne wartości T 2 są trudne do znalezienia. Zwykle T 2 jest konwertowane na statystykę F.

W przypadku testu wielowymiarowego z jedną próbą hipoteza jest taka, że średni wektor ( μ ) jest równy danemu wektorowi ( μ 0 ). Statystyka testu to t 2 Hotellinga :

gdzie n jest wielkością próbki, x jest wektorem średnich kolumnowych, a S jest macierzą kowariancji próbki m × m .

W przypadku testu wielowymiarowego dla dwóch prób hipoteza jest taka, że średnie wektory ( μ 1 , μ 2 ) dwóch próbek są równe. Statystyka testowa to dwie próby Hotellinga t 2 :

Wdrożenia oprogramowania

Wiele programów do obsługi arkuszy kalkulacyjnych i pakietów statystycznych, takich jak QtiPlot , LibreOffice Calc , Microsoft Excel , SAS , SPSS , Stata , DAP , gretl , R , Python , PSPP , MATLAB i Minitab , zawiera implementacje testu t Studenta.

| Język/Program | Funkcjonować | Uwagi |

|---|---|---|

| Microsoft Excel sprzed 2010 r. | TTEST(array1, array2, tails, type) |

Zobacz [1] |

| Microsoft Excel 2010 i nowsze | T.TEST(array1, array2, tails, type) |

Zobacz [2] |

| LibreOffice Calc | TTEST(Data1; Data2; Mode; Type) |

Zobacz [3] |

| Arkusze Google | TTEST(range1, range2, tails, type) |

Zobacz [4] |

| Pyton | scipy.stats.ttest_ind(a, b, equal_var=True) |

Zobacz [5] |

| MATLAB | ttest(data1, data2) |

Zobacz [6] |

| Matematyka | TTest[{data1,data2}] |

Zobacz [7] |

| r | t.test(data1, data2, var.equal=TRUE) |

Zobacz [8] |

| SAS | PROC TTEST |

Zobacz [9] |

| Jawa | tTest(sample1, sample2) |

Zobacz [10] |

| Julia | EqualVarianceTTest(sample1, sample2) |

Zobacz [11] |

| Stata | ttest data1 == data2 |

Zobacz [12] |

Zobacz też

Bibliografia

Cytaty

Źródła

- O'Mahony, Michael (1986). Sensoryczna ocena żywności: metody i procedury statystyczne . CRC Naciśnij . P. 487. Numer ISBN 0-82477337-3.

- Prasa, William H.; Teukolsky, Saul A.; Vetterling, William T.; Flannery, Brian P. (1992). Przepisy numeryczne w C: The Art of Scientific Computing . Wydawnictwo Uniwersytetu Cambridge . P. 616 . Numer ISBN 0-521-43108-5.

Dalsza lektura

- Boneau, C. Alan (1960). „Skutki naruszeń założeń leżących u podstaw testu t ”. Biuletyn Psychologiczny . 57 (1): 49-64. doi : 10.1037/h0041412 . PMID 13802482 .

- Edgell, Stephen E.; Południe, Sheila M. (1984). „Wpływ naruszenia normalności na test t współczynnika korelacji”. Biuletyn Psychologiczny . 95 (3): 576-583. doi : 10.1037/0033-2909.95.3.576 .

Zewnętrzne linki

- "Test studencki" , Encyklopedia Matematyki , EMS Press , 2001 [1994]

- Trochim, William MK „ Test T ”, Baza wiedzy o metodach badawczych , conjoint.ly

- Wykład z ekonometrii (temat: testowanie hipotez) na YouTube autorstwa Marka Thoma